I robot di Google che si aiutano a vicenda per imparare da soli

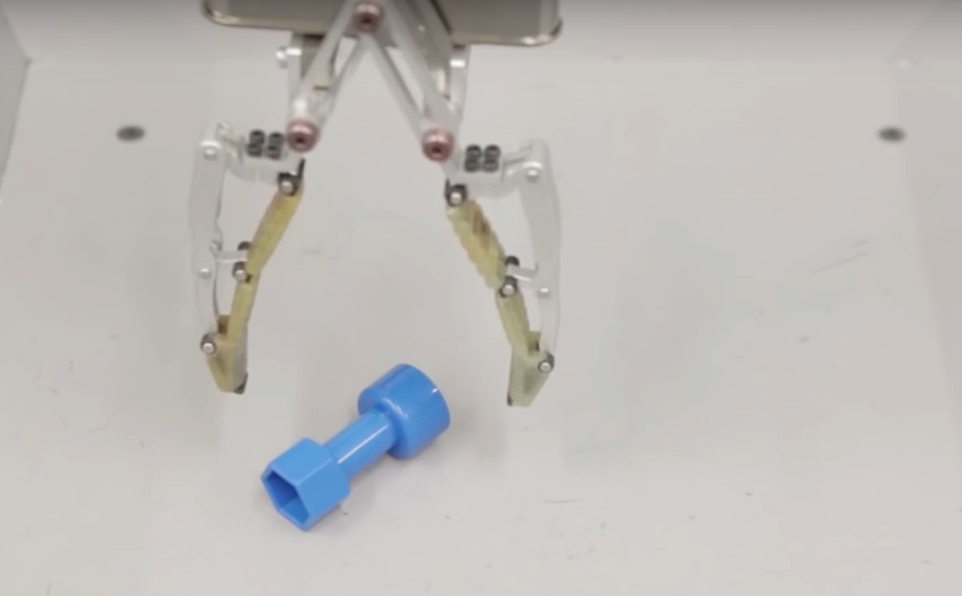

Da tempo i ricercatori di Google sono al lavoro per migliorare i sistemi di intelligenza artificiale e di recente hanno ottenuto risultati molto incoraggianti, con un computer che ha battuto il campione mondiale del complicatissimo gioco da tavolo cinese Go. Come spiega uno dei principali responsabili della ricerca presso Google, Sergey Levine, in un recente esperimento 14 bracci robotici sono stati collegati tra loro e a un sistema informatico che imita il modo in cui si organizzano i neuroni. Sulla base delle loro esperienze, i robot hanno imparato a raccogliere nel modo migliore piccoli oggetti come una tazza o del nastro adesivo.

Intorno alla fine del primo anno di vita, la maggior parte dei bambini ha imparato come si raggiungono e tengono in mano gli oggetti a seconda delle loro caratteristiche, ma per un computer è più difficile, soprattutto se non è stato programmato prima per imparare a riconoscere e gestire ciò che ha davanti. I ricercatori volevano capire se fosse possibile istruire i robot in modo da fargli raccogliere oggetti che non avevano mai visto prima. Con oltre 800mila prese eseguite, i cui dati sono stati analizzati dal software che imita i neuroni, i robot hanno imparato da soli a raccogliere le cose, senza che fosse necessario programmarli.