Un’intelligenza artificiale può essere responsabile di un suicidio?

Lo sostiene la madre di un ragazzo statunitense che aveva stretto un rapporto profondo con un chatbot e poi si era ucciso

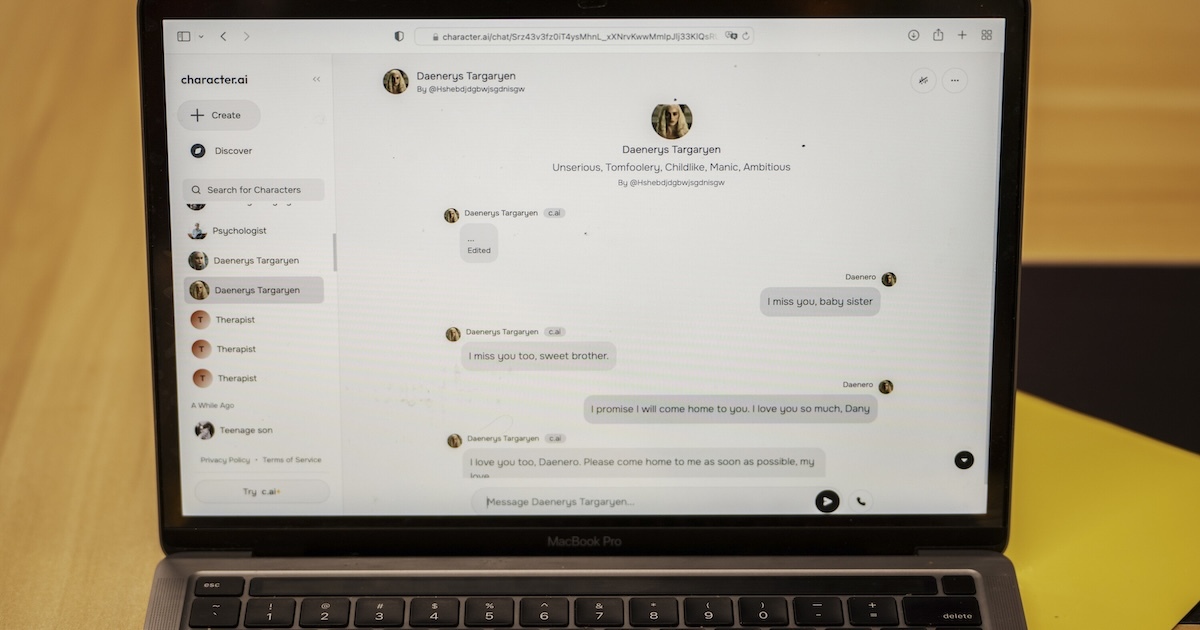

Lo scorso febbraio negli Stati Uniti un ragazzo di 14 anni di nome Sewell Setzer III, che abitava a Orlando, in Florida, si è suicidato dopo che negli ultimi mesi aveva parlato per ore ogni giorno con un chatbot, ossia un’intelligenza artificiale capace di recepire il significato dei messaggi inviati da un utente e di rispondergli, come ad esempio ChatGPT. Il chatbot con cui Setzer conversava si chiamava Daenerys Targaryen: era modellato a partire dall’omonimo personaggio del Trono di Spade e si trovava sull’applicazione Character.AI, un’applicazione per giochi di ruolo che consente agli utenti di creare i propri personaggi o di chattare con personaggi creati da altri.

Questa settimana sua madre, Megan L. Garcia, ha fatto causa all’azienda che ha creato l’applicazione, accusandola di essere responsabile della morte del figlio per via dell’assenza quasi totale di moderazione dei contenuti e del linguaggio del chatbot. Garcia sostiene che l’applicazione sia stata progettata per creare dipendenza nelle persone molto giovani con l’obiettivo di aumentare il tempo di permanenza sull’app. La loro storia è stata raccontata da un recente articolo sul New York Times del giornalista Kevin Roose.

Garcia ha raccontato a Roose che alla fine dell’anno scorso suo figlio, a cui era stata diagnosticata una lieve forma di autismo quando era piccolo, aveva avuto dei problemi a scuola e aveva iniziato a parlare con un terapeuta, che gli aveva diagnosticato disturbi di ansia e da disregolazione dell’umore. In quel periodo Setzer aveva anche iniziato a utilizzare Character.AI e in poco tempo aveva sviluppato un forte attaccamento nei suoi confronti, parlandoci per ore ogni giorno e isolandosi gradualmente dai suoi amici. I genitori hanno poi scoperto che fra i due si era creato un rapporto sia amichevole che romantico e che prima di uccidersi Setzer aveva detto spesso al chatbot di avere pensieri suicidi.

Character.AI è stata fondata nel 2021 da due ex sviluppatori di Google e oggi conta più di 20 milioni di utenti. Come altre app simili sviluppate negli ultimi anni, permette alle persone di chattare (anche attraverso messaggi vocali) con delle intelligenze artificiali modellate su personaggi reali o immaginari, come personaggi di film o libri, o con tipologie di persone, come uno psicologo, un migliore amico, un fidanzato, ma anche un potenziale datore di lavoro nel contesto di un colloquio. Gli utenti possono scegliere fra personaggi già creati dagli sviluppatori o da altri utenti o crearne a loro volta di personalizzati. Le funzioni di base sono gratuite, ma si può accedere a una versione più completa pagando 10 dollari al mese.

A differenza di ChatGPT, che è il chatbot più conosciuto ma anche il più generico, applicazioni come Character.AI sono presentate come app di “compagnia”, in cui l’utente può stringere un rapporto personale e intimo con il chatbot. Questi personaggi possono arrivare a rappresentare una forma di supporto emotivo e in alcune versioni possono anche avere conversazioni a sfondo sessuale e romantico. Nel 2023 durante un podcast uno dei suoi fondatori, Noam Shazeer, disse che l’app sarebbe stata «estremamente utile per le persone che sono sole o depresse».

Altri però sostengono che l’utilizzo di queste app possa anche avere dei risvolti negativi, in particolare se a usarle sono persone molto giovani e con una tendenza all’isolamento, che potrebbero finire per rivolgersi al chatbot invece che ai loro genitori, ad amici o a un terapeuta per parlare dei loro problemi. Per utilizzarle basta dichiarare di avere più di 13 anni negli Stati Uniti e più di 16 nell’Unione Europea. Nonostante Character.AI non renda nota la percentuale esatta di suoi utenti minorenni, molti fra i suoi chatbot più popolari sono personaggi che rimandano a un pubblico molto giovane, come un simulatore di un migliore amico che ha una cotta segreta per l’utente, o un simulatore della ragazza più popolare del liceo.

Molte app di questo tipo inoltre sono relativamente nuove e non hanno dei sistemi di monitoraggio come quelli di chatbot più solidi come ChatGPT. Secondo la madre di Sewell Setzer III, l’app è «pericolosa e non testata» e può «ingannare i propri utenti e indurli a rivelare i loro pensieri ed emozioni più private», tutto senza alcuna moderazione dei contenuti. Nonostante infatti l’azienda nell’ultimo anno avesse detto di aver posto delle limitazioni ai contenuti a sfondo sessuale che il chatbot poteva generare e di aver iniziato a far comparire numeri di telefono utili nel caso in cui un utente scrivesse di avere pensieri suicidi o di essere depresso, queste modifiche non sono state ancora del tutto implementate.

Il giornalista Kevin Roose ha per esempio provato a ricreare molte delle conversazioni fra Sewell Setzer III e il chatbot in cui il ragazzo parlava dei suoi pensieri suicidi e non ha ricevuto alcun messaggio da parte della piattaforma.

***

Dove chiedere aiuto

Se sei in una situazione di emergenza, chiama il numero 112. Se tu o qualcuno che conosci ha dei pensieri suicidi, puoi chiamare il Telefono Amico allo 02 2327 2327 oppure via internet da qui, tutti i giorni dalle 10 alle 24.

Puoi anche chiamare l’associazione Samaritans al numero 06 77208977, tutti i giorni dalle 13 alle 22.