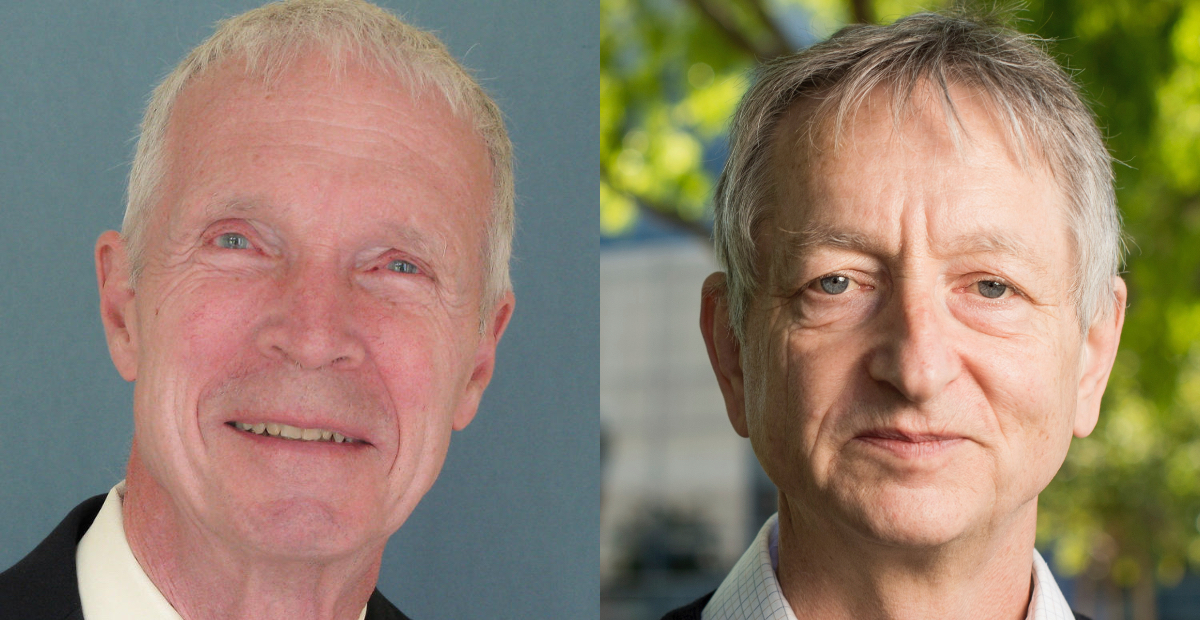

Il Nobel per la Fisica a John J. Hopfield e Geoffrey E. Hinton

Per i loro studi nello sviluppo dei sistemi di apprendimento automatico, alla base della rapida evoluzione dei sistemi di intelligenza artificiale degli ultimi anni

Il Premio Nobel per la Fisica del 2024 è stato assegnato a John J. Hopfield e Geoffrey E. Hinton «per le scoperte e le invenzioni fondamentali che consentono l’apprendimento automatico con reti neurali artificiali».

Hopfield e Hinton hanno preso in prestito sistemi e strumenti dalla fisica per sviluppare i sistemi di apprendimento automatico (“machine learning”) che oggi fanno funzionare alcuni dei più famosi sistemi di intelligenza artificiale. I loro studi hanno permesso di sviluppare soluzioni per trovare andamenti e modelli nei dati, derivando da questi le informazioni. Il lavoro di Hopfield e Hinton è stato quindi fondamentale per sviluppare le tecnologie che fanno funzionare le reti neurali, cioè i sistemi che provano a imitare le nostre capacità di apprendimento e della memoria.

Nei primi tempi dell’informatica, gli algoritmi erano scritti dalle persone e la loro principale utilità era di indicare al sistema che cosa fare nel caso di una determinata circostanza, una indicazione piuttosto semplice riassumibile in: “Se si verifica questo allora fai quello”. Algoritmi, codice e altre variabili determinano il funzionamento di un software, cioè di un programma informatico, come il browser sul quale si è caricata la pagina che state leggendo in questo momento. Un algoritmo può essere definito come una sequenza finita di istruzioni per risolvere un determinato insieme di richieste o per calcolare un risultato.

Ci sono molti ambiti in cui i dati e i “se questo allora quello” da considerare sono tantissimi, una quantità tale da non poter essere gestita con istruzioni scritte a mano: più dati e più variabili portano a più eccezioni da prevedere e indicare al software per dire come comportarsi, ma se le eccezioni sono miliardi il compito non può essere assolto da dieci, cento o mille programmatori.

Questa difficoltà è stata superata con il machine learning (ML), cioè l’attività di apprendimento dei computer tramite i dati. Mette insieme l’informatica con la statistica, con algoritmi che man mano che analizzano i dati trovando andamenti e ripetizioni, sulla base dei quali possono fare previsioni. L’apprendimento può essere supervisionato, cioè basato su una serie di esempi ideali, oppure non supervisionato, in cui è il sistema a trovare i modi in cui organizzare i dati, senza avere specifici obiettivi.

Messa in altri termini: per fare una torta il software tradizionale segue una ricetta con l’elenco degli ingredienti e le istruzioni passo passo, mentre un software basato sul ML impara attraverso degli esempi osservando una grande quantità di torte, sbagliando e riprovando fino a quando non ottiene un risultato in linea con la richiesta iniziale. Per farlo ha bisogno di una rete neurale artificiale, un modello di elaborazione dei dati che si ispira al funzionamento delle reti neurali biologiche, come quelle nel nostro cervello.

Le reti neurali artificiali hanno richiesto decenni per essere sviluppate e perfezionate, con grandi difficoltà legate soprattutto alle ridotte capacità di elaborazione dei computer per buona parte del Novecento. Le cose iniziarono a cambiare nei primi anni Ottanta quando il fisico John Hopfield fissò in un modello matematico i principi per realizzare una rete neurale che simula la nostra capacità di ricordare e di ricostruire le immagini nella nostra mente. Hopfield aveva sviluppato il modello attingendo dalle proprie conoscenze in fisica e in particolare dalle proprietà magnetiche di alcuni materiali che condizionano il comportamento dei loro atomi.

Una rete di Hopfield funziona memorizzando dei modelli, come immagini e schemi, e poi richiamandoli quando riceve un input parziale oppure distorto come un’immagine incompleta o poco definita. Il sistema prova a minimizzare l’energia complessiva, cioè cerca di raggiungere uno stato stabile riducendo il disordine che rende instabile lo stato di partenza della rete. In pratica, quando la rete riceve un’immagine incompleta o rumorosa, “esplora” varie possibili configurazioni per ridurre l’energia complessiva, finché non trova una configurazione che corrisponde a un modello memorizzato, cioè a un’immagine “stabile” e riconoscibile. In questo modo può dire che una certa immagine mai analizzata prima assomiglia a una delle immagini che ha già in memoria.

Negli anni seguenti alla pubblicazione del modello di Hopfield, Geoffrey Hinton lavorò a un sistema che aggiungeva alcuni principi di fisica statistica, cioè quella parte della fisica che utilizza metodi statistici per risolvere problemi. Elaborò la “macchina di Boltzmann”, basata sulla distribuzione che porta il nome del fisico austriaco Ludwig Boltzmann.

La macchina di Boltzmann è un tipo di rete neurale usato per riconoscere particolari schemi nei dati. Per farlo utilizza due tipi di nodi: i nodi visibili, che ricevono l’informazione, e i nodi nascosti, che aiutano a elaborare queste informazioni senza essere visibili direttamente. Questi nodi interagiscono tra loro e influenzano l’energia complessiva della rete.

La rete funziona aggiornando uno alla volta i valori dei nodi, fino a raggiungere uno stato stabile, in cui il comportamento complessivo della rete non cambia più. Ogni possibile configurazione della rete ha una probabilità, determinata dall’energia della rete stessa. In questo modo, la macchina può generare nuovi modelli partendo da ciò che ha imparato. La macchina impara dagli esempi durante il suo allenamento: i valori delle connessioni tra i nodi vengono aggiornati in modo che i modelli presentati abbiano la probabilità più alta di essere ricreati, quindi più un modello viene ripetuto, più aumenta la probabilità che la rete lo ricordi.

Con i loro lavori ispirati alla fisica, Hopfield e Hinton hanno dato un contributo fondamentale allo sviluppo del machine learning, soprattutto negli ultimi 15 anni grazie all’aumentata capacità di calcolo dei processori. A distanza di anni, i grandi progressi partiti dalla fisica potrebbero avere importanti ricadute per la fisica stessa con l’elaborazione di nuovi modelli per effettuare misurazioni più accurate, per esempio escludendo il rumore di fondo nello studio delle onde gravitazionali. Le possibilità di impiego dei sistemi di intelligenza artificiale sono comunque sterminate e toccano praticamente qualsiasi ambito della ricerca.

John J. Hopfield è nato nel 1933 a Chicago, negli Stati Uniti, ed è docente alla Princeton University.

Geoffrey E. Hinton è nato nel 1947 a Londra, nel Regno Unito, ed è docente presso l’Università di Toronto in Canada. È stato ricercatore e dirigente di Google, incarico che ha lasciato lo scorso anno sollevando alcune perplessità e preoccupazioni sulla rapida evoluzione di alcuni sistemi di intelligenza artificiale.