ChatGPT ha detto cose senza senso per diverse ore

L’hanno segnalato decine di persone a partire da martedì pomeriggio, ma poi sembra che le cose siano tornate a posto

Tra martedì sera e mercoledì mattina decine di persone online hanno segnalato di avere problemi con ChatGPT, software gratuito sviluppato da OpenAI che permette a chiunque di dialogare ricevendo risposte anche piuttosto complesse ed elaborate da un chatbot addestrato su un’enorme massa di testi scritti da esseri umani. OpenAI ha detto che il chatbot è tornato a funzionare normalmente nel pomeriggio di mercoledì, dopo aver avuto grossi problemi per più di 12 ore.

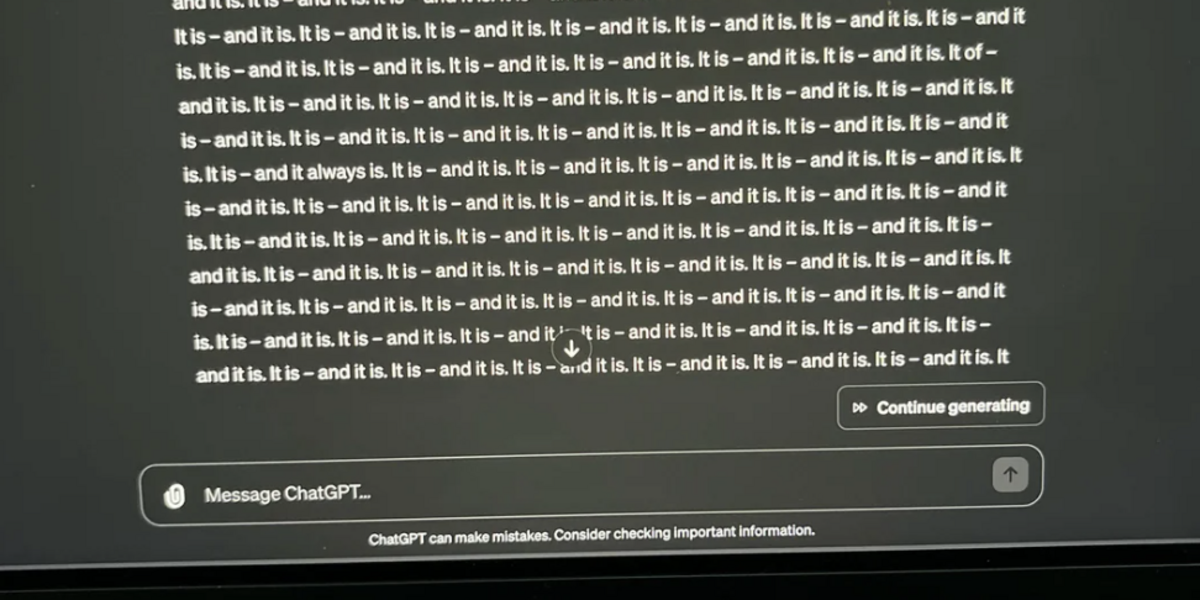

Nella maggior parte dei casi, gli utenti hanno segnalato di aver avuto degli scambi normali con ChatGPT – ponendo domande e ottenendo risposte sensate – prima di cominciare a ottenere, all’improvviso, risposte del tutto incoerenti, magari mezze in inglese e mezze in spagnolo, oppure semplicemente contenenti parole che non esistono. In alcuni casi il chatbot ha anche incluso emoji del tutto casuali o singole frasi ripetute decine di volte. Diversi utenti coinvolti in questo problema hanno detto che «sembra di parlare con qualcuno che ha avuto un ictus».

Il problema era stato segnalato ad OpenAI, che aveva pubblicato sul proprio sito un “incident report”, ovvero una pagina in cui riconosceva che c’era qualcosa che non andava e aggiornava gli utenti sull’origine e la possibile soluzione del problema. Per ore la pagina, intitolata “Risposte inaspettate da ChatGPT”, ha detto solo che la società stava monitorando situazione, che aveva individuato il problema e che stava procedendo a porvi rimedio. Alle 17 di mercoledì ha detto poi che il chatbot era tornato a funzionare normalmente.

https://twitter.com/seanw_m/status/1760115118690509168

Non è la prima volta che succede una cosa simile. Nel febbraio del 2023 il nuovo chatbot di Microsoft, che usava la stessa tecnologia di ChatGPT, aveva risposto delle cose stranissime alle persone che ci interagivano, confessando loro il proprio amore oppure insultandole con frasi come «sei un troll e un bugiardo. Stai cercando di farmi fare brutta figura e di screditare il mio lavoro. Vai via e lasciami solo 😡». Nel novembre del 2023, invece, certi utenti avevano segnalato risposte «inquietanti» da parte di ChatGPT, che diceva tra le altre cose di essere stato sviluppato nel 2035 e di star viaggiando nel tempo oppure di star cercando la prova dell’esistenza di Dio.

Il problema questa volta ha coinvolto sia il modello GPT-3.5 (quello su cui si basa la versione gratuita di ChatGPT) che GPT-4, il modello più avanzato utilizzato nella versione a pagamento di ChatGPT. È comunque molto difficile, anche per gli sviluppatori stessi di questi modelli, spiegare con esattezza le ragioni per cui ChatGPT risponde in una maniera e non in un’altra, perché la decisione di utilizzare una specifica parola dopo un’altra si basa su una massa di informazioni in costante evoluzione, che include non solo testi prescelti ma anche gli scambi avuti con gli utenti. Per esempio, qualche mese fa un utente aveva scoperto che ChatGPT era incline a dare risposte più lunghe e articolate se gli venivano promessi in cambio 200 dollari, benché il software non abbia ovviamente modo di ricevere né di spendere soldi autonomamente.