Perché le intelligenze artificiali funzionino serve che le intelligenze umane facciano lavori noiosissimi

The Verge racconta i compiti ingrati e ripetitivi svolti dai lavoratori, spesso in paesi in via di sviluppo, per “educare” i software

Da DALL·E a ChatGPT, negli ultimi mesi sono stati presentati al pubblico tantissimi nuovi software piuttosto complessi basati sul machine learning, ovvero su attività di apprendimento automatico dei computer a partire da milioni di dati, definiti genericamente intelligenze artificiali. Le aziende e gli individui che investono sullo sviluppo di queste tecnologie spesso ne parlano con toni tra l’enfatico e il profetico, sostenendo che nei prossimi anni la cosiddetta “intelligenza artificiale” renderà obsoleti tantissimi compiti o interi lavori oggi svolti da esseri umani. Nelle ultime settimane, però, diverse inchieste hanno esplorato un tema di cui le stesse aziende sembrano avere molta meno voglia di parlare: quello dei milioni di persone che svolgono lavori noiosi e spesso poco pagati per assicurare che quelle stesse tecnologie risultino utili e utilizzabili.

«L’attuale ascesa dell’intelligenza artificiale – i chatbot che suonano umani; le opere d’arte generate a partire da semplici suggerimenti; le valutazioni multimiliardarie delle aziende che lavorano a queste tecnologie – è stata resa possibile da un’impresa senza precedenti fatta di lavori noiosi e ripetitivi», ha scritto il giornalista Josh Dzieza in un approfondito articolo su The Verge.

– Leggi anche: Bisogna capirsi su cosa sia “l’intelligenza artificiale”

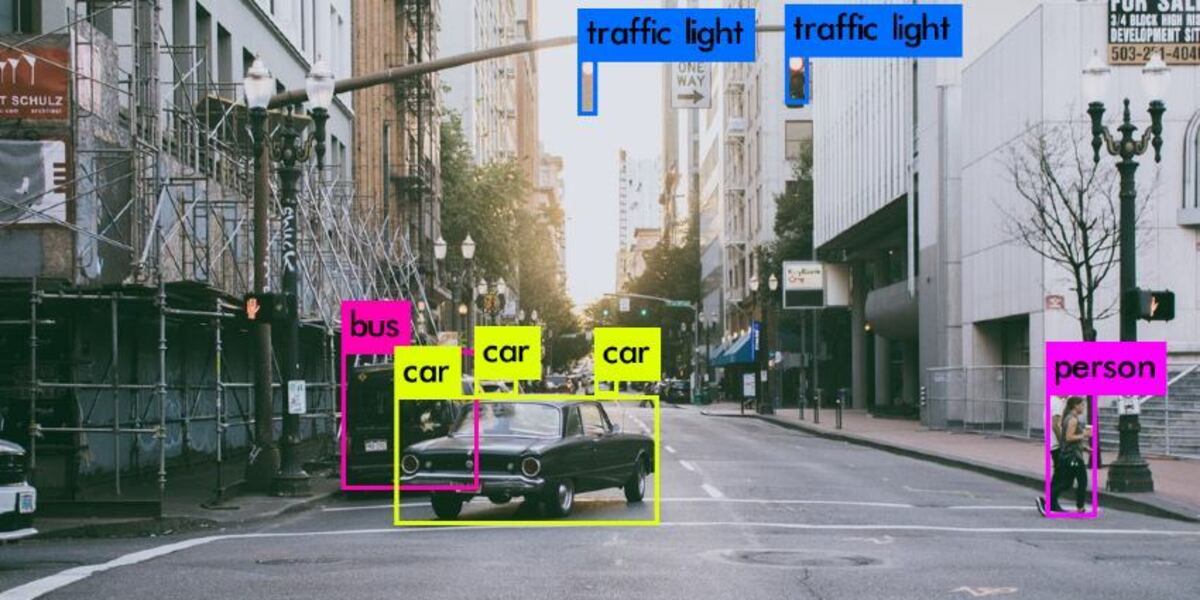

Infatti, dopo anni di stasi nei tentativi di migliorare le reti neurali di riconoscimento delle immagini – una delle tecnologie che hanno reso possibili gli algoritmi che oggi chiamiamo “intelligenze artificiali” – il campo tornò a evolvere quando, nel 2007, la professoressa dell’università di Princeton Fei-Fei Li si rese conto che queste reti dovevano essere addestrate su milioni, e non soltanto decine di migliaia, di immagini. Tutte quelle immagini andavano però “etichettate” manualmente da esseri umani, ovvero descritte con un certo grado di dettaglio e secondo categorie specifiche in modo da essere rese leggibili dai computer.

Per farlo, la squadra di Li si rivolse a Mechanical Turk, una piattaforma appartenente ad Amazon che permette di reclutare persone in tutto il mondo e chiedere loro di completare piccoli lavori a distanza a basso costo. Il risultato di quegli sforzi fu ImageNet, un massiccio set di dati che contiene oltre 14 milioni di immagini, tutte annotate manualmente con descrizioni degli oggetti che rappresentano, divise in più di 200mila categorie. Il database, messo a disposizione gratuitamente online, è considerato centrale nel rapido sviluppo delle intelligenze artificiali degli ultimi anni.

Il “data labeling” – ovvero l’atto di “etichettare” vari tipi di dati, che si tratti di audio, video, foto o testi – non è più l’unico tipo di lavoro umano necessario per sviluppare e migliorare il rendimento delle tecnologie basate sul machine learning. Negli ultimi anni si è affiancato il “reinforcement learning with human feedback” (“apprendimento rinforzato con feedback umano”, RLHF), ovvero la pratica di assumere esseri umani per giudicare i risultati prodotti dalle intelligenze artificiali, indirizzandoli nella direzione giusta e quindi contribuendo a perfezionarli.

Nella pratica, per i lavoratori il RLHF prende la forma di tantissimi compiti diversi. «Ci sono persone che classificano il contenuto dei video di TikTok dal punto di vista delle emozioni che suscitano, che identificano nuovi tipi di spam via email e capiscono se un annuncio online è sessualmente provocante. Altri esaminano le transazioni con carta di credito e cercano di capire a quale tipo di acquisto si riferiscono, o controllano i vestiti consigliati dagli algoritmi dei siti di e-commerce per decidere se all’acquirente di una specifica maglietta potrebbe davvero piacerne un’altra», scrive Dzieza.

Si tratta di lavori ripetitivi, ma spesso abbastanza difficili. Tradurre la complessità della realtà in codici comprensibili a una macchina non è semplice, perché richiede di «istruire gli umani a classificare il mondo con perfetta coerenza, anche se questo vuol dire creare categorie che nessun essere umano userebbe mai» scrive Dzieza. Un esempio è un’immagine con diverse magliette, una delle quali riflessa in uno specchio: per un essere umano quel riflesso non conterebbe come maglietta, ma per educare un’intelligenza artificiale sarebbe necessario classificarla così, altrimenti il modello finale non funzionerà. Significa ragionare in modo «molto, molto letterale: pensare, come ha detto uno di questi lavoratori, come un robot».

Questo tipo di lavoro è impiegato massicciamente da società enormi come Google, Microsoft e OpenAI, che spesso lo affidano ad aziende esterne con sede in paesi in via di sviluppo, come Kenya e Nepal, dove il costo della manodopera è molto più basso, oppure a piattaforme come Mechanical Turk e Clickworker, dove chiunque può registrarsi per guadagnare piccole somme svolgendo singoli compiti slegati tra loro. Le aziende specializzate in questo tipo di lavori valgono ormai miliardi di dollari: Scale AI, fondata nel 2016 dall’allora diciannovenne Alexandr Wang, nel 2021 era valutata 7,3 miliardi di dollari e aveva tra i propri clienti OpenAI e l’esercito statunitense. Diverse altre aziende più piccole nel settore appartengono a Scale AI, senza che questo sia mai rivelato ai dipendenti.

Non è facile ricostruire questi rapporti d’affari: le aziende che appaltano questi compiti chiedono spesso la massima riservatezza, perché non vogliono far trapelare troppe informazioni sul tipo di tecnologie a cui stanno lavorando. «Ai lavoratori viene chiesto ripetutamente di non parlare a nessuno del proprio lavoro, nemmeno ad amici e colleghi, ma c’è comunque un sistema di alias aziendali, progetti nascosti dietro a nomi in codice e un’estrema divisione del lavoro per assicurare che nessuno abbia mai abbastanza informazioni su ciò che sta facendo per parlarne con qualcuno, anche se volesse farlo», secondo Dzieza. Per lo stesso motivo non esistono stime sul numero di persone impiegate in questo settore: si sa solo che è in crescita.

Le aziende tecnologiche tendono spesso a sminuire l’importanza dei contributi umani per l’avanzamento delle loro tecnologie. Interpellata da The Verge, la portavoce di Google Courtenay Mencini ha detto per esempio che l’RLHF «non ha un impatto diretto sull’addestramento dei nostri algoritmi. Direi piuttosto che sono un dato sui tanti che vengono presi in considerazione nella fase di testing».

Secondo vari esperti indipendenti intervistati da Dzieza, però, l’RLHF è in assoluto una delle cose che più hanno reso possibile la qualità di programmi come ChatGPT. A loro avviso, le grandi aziende sminuiscono deliberatamente il loro impatto in pubblico perché ammettere che queste tecnologie dipendano ancora moltissimo dall’intervento umano rovina un po’ la narrazione secondo cui siano macchine intelligentissime, a un passo dall’autocoscienza.

Al contempo, si tratta di compiti spesso sottopagati e piuttosto ingrati, che talvolta espongono i lavoratori a scene di violenza e altri contenuti sgradevoli. La maggior parte dei lavori viene pagata a cottimo, ed è difficile prevedere quanto si verrà pagati e quanto tempo durerà un lavoro. Una portavoce di Scale AI ha detto a The Verge che i compensi dipendono dalle specifiche di un progetto, dalle competenze richieste, dal costo della vita nella regione in cui vivono i lavoratori e da altri fattori «per garantire un compenso equo e competitivo». Secondo la rivista, i lavoratori di Remotasks con sede negli Stati Uniti generalmente guadagnano tra i 10 e i 25 dollari l’ora, mentre quelli che fanno lo stesso lavoro in Kenya guadagnano tra 1 e 3 euro l’ora. Molti, inoltre, ritengono alienante il fatto di non avere la minima idea del motivo per cui stanno facendo quello che fanno.

«L’annotazione rimane una parte fondamentale nella creazione dell’intelligenza artificiale, ma spesso tra gli ingegneri si ha la sensazione che sia un prerequisito passeggero e scomodo, molto meno affascinante che costruire modelli», continua Dzieza. L’idea, dice, è che presto non ci sarà più bisogno di loro, perché i dataset saranno sufficientemente completi: «ma il lavoro di etichettatura non è mai veramente finito. I sistemi di apprendimento automatico sono “fragili”, inclini a fallire quando incontrano qualcosa che non è ben rappresentato nei dati su cui sono stati addestrati. Questi fallimenti, chiamati “casi limite”, possono avere gravi conseguenze. Più sistemi di intelligenza artificiale vengono diffusi nel mondo, anche per fare cose come dispensare consulenza legale e assistenza medica, più casi limite ci saranno, e più esseri umani saranno necessari per risolverli». Per ora, tutti i tentativi di addestrare modelli affinché addestrino e correggano altri modelli hanno portato a un peggioramento delle loro performance.