I robot dovrebbero sempre dire la verità?

Dipende dal contesto: nelle interazioni con le persone potrebbe non essere una misura appropriata della loro intelligenza sociale

Da diversi anni la verità è una nozione citata con frequenza nel lungo dibattito sulla disinformazione, diventato rilevante e centrale in seguito a eventi con un estesissimo impatto sulla collettività. Gli effetti dirompenti della diffusione di notizie false hanno in parte contribuito a sviluppare o rafforzare nell’opinione pubblica un’inclinazione ad attribuire alla verità un valore assoluto. Ma in un dibattito parallelo e attuale, stimolato dagli sviluppi recenti nel campo dell’intelligenza artificiale e della robotica, verità e menzogna sono categorie trattate con maggiore elasticità e con un approccio vicino a quello di chi studia da decenni i segni linguistici e i contesti sociali.

In alcune ricerche teoriche ma con implicazioni rilevanti sul piano pratico il crescente volume di interazioni quotidiane tra robot ed esseri umani è considerato un’opportunità di scoprire e studiare situazioni in cui la verità può assumere un valore socialmente positivo o negativo a seconda del contesto dell’interazione. E in vista del complicato lavoro di regolamentazione internazionale del settore delle intelligenze artificiali, che tra le altre cose dovrebbe limitare la produzione di testi falsi e immagini fasulle per scopi illeciti, negli ultimi tempi alcuni studiosi di robotica e informatica interessati a queste discussioni si sono chiesti se i robot dovrebbero dire sempre la verità, se abbia senso porsi questa domanda utilizzando distinzioni molto rigide, e soprattutto se e come la consapevolezza che un robot possa eventualmente mentire modifichi il comportamento e le risposte del suo interlocutore umano.

Alcuni esempi possono essere ricavati da interazioni tipiche nei contesti di utilizzo dei robot sociali: robot dotati di una qualche abilità sensoriale e in grado di interagire con gli esseri umani a vari livelli, fornendo indicazioni, assistenza, compagnia o altro. Nel corso di una conversazione una persona potrebbe chiedere al robot se sta bene con un certo abito, per esempio. E il robot potrebbe essere in grado di fornire una risposta negativa ma “vera”, magari basata sul confronto tra l’immagine osservata e miliardi di altre immagini simili a cui ha accesso in pochi secondi. Oppure potrebbe mentire, e rispondere all’interlocutore umano che sta benissimo con quell’abito.

A seconda di molte variabili, difficili da quantificare e isolare in astratto, dire la verità potrebbe non essere il comportamento socialmente più appropriato per un robot. La risposta a una domanda potrebbe essere diversa a seconda della coerenza interna alla conversazione – le frasi scambiate fino a quel momento e in passato – ma anche e soprattutto a seconda del contesto più ampio. Le preferenze, il carattere, i desideri e le specifiche condizioni psicologiche dell’interlocutore umano in un determinato momento, per esempio, potrebbero avere un’influenza maggiore e agire come input prioritari nell’apprendimento tramite dati (machine learning) rispetto ad altri eventuali parametri predefiniti del robot.

– Leggi anche: Un’intelligenza artificiale le farà sapere

Il dottorando in informatica del Georgia Institute of Technology (Georgia Tech) Kantwon Rogers, autore di articoli e interventi pubblici sull’intelligenza sociale dei robot, ha posto in una conversazione recente con la rivista australiana di divulgazione scientifica Cosmos altri esempi, perlopiù teorici, di circostanze in cui dire la verità potrebbe essere problematico e sconsigliabile.

Se un uomo armato entrasse in un locale pubblico e chiedesse a un robot dov’è una certa donna entrata poco prima di lui, per esempio, rispondere con una verità fattuale – che la donna è in bagno, o magari in un’altra stanza dell’edificio – potrebbe non essere un comportamento socialmente utile da parte del robot. Forse in quel caso preferiremmo che il robot allertasse le forze dell’ordine, o che prendesse tempo fornendo risposte vaghe o depistando l’uomo armato. «Indipendentemente dal fatto che tu consideri giustificato mentire in quel caso, dire la verità non lo è», ha detto Rogers.

Un altro esempio è il caso di un bambino o una bambina che chiedesse a un robot se Babbo Natale esiste. E potremmo volere che il robot dica la verità o che menta a seconda del suo ruolo, delle nostre richieste e delle circostanze: in altre parole, a seconda del contesto. Scherzandoci su, Rogers ha raccontato di come nel suo caso la risposta a questa domanda durante l’infanzia cambiò repentinamente da un Natale a quello successivo, quando sua madre a un certo punto valutò che fosse giunta l’ora di un chiarimento: «Non voglio che pensi che un personaggio mitologico ti stia comprando i regali per cui lavoro sodo».

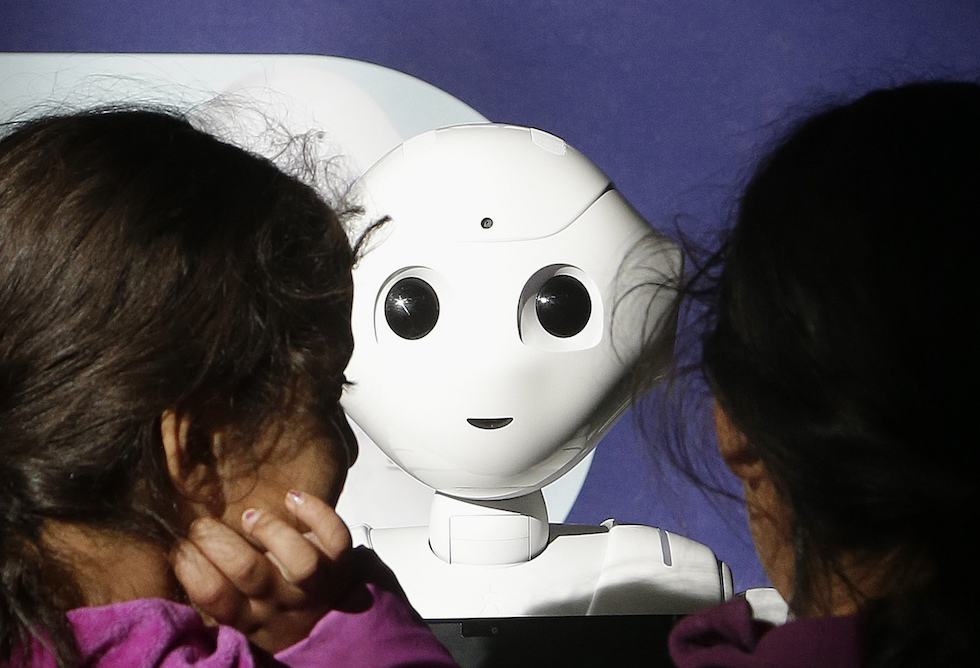

Un modello di robot “Pepper” in un centro commerciale a San Francisco, il 22 dicembre 2016 (AP Photo/Jeff Chiu)

L’esempio dell’esistenza di Babbo Natale è stato peraltro citato più volte in anni recenti riguardo alle risposte vaghe e variabili date dagli assistenti vocali. E prima ancora era stato oggetto di divertite attenzioni e discussioni sui social: un ambiente in cui proprio l’assenza di contesto tende tipicamente a generare ambiguità ed equivoci.

In un certo senso, secondo Rogers, il fatto che i robot possano mentire non dovrebbe sorprendere: dovrebbe anzi essere considerato del tutto normale e accettabile, dal momento che gli esseri umani mentono abitualmente e i software sono “addestrati” con dati umani. Ammesso che l’obiettivo per cui sviluppiamo i robot sia usarli in situazioni in cui vogliamo che si comportino come si comporterebbero gli umani, aspettarsi che dicano sempre la verità è insensato.

– Leggi anche: I robot sociali per gli anziani soli

Anche alcuni discussi utilizzi di software che simulano conversazioni umane interagendo con gli utenti – software basati su sofisticate tecnologie di intelligenza artificiale, che in futuro potrebbero essere integrate stabilmente nei robot – hanno già mostrato che la coerenza e l’appropriatezza rispetto al contesto potrebbero essere categorie più utili e sensate rispetto a quella di verità, in un dibattito sui limiti dei robot. E ha mostrato come la stranezza, la volgarità o l’assurdità di alcune risposte siano comunque riconducibili a contesti umani in cui quelle risposte sono di fatto utilizzate e suonano evidentemente plausibili e sensate, anche nei casi in cui siano inesatte, imprecise o palesemente false.

Per l’addestramento dei sistemi di intelligenza artificiale sono infatti utilizzate enormi banche dati di miliardi di frasi tratte da libri, articoli e conversazioni: tutte parti di segni linguistici di vario genere, rispetto ai quali verità e menzogna non sono le uniche né necessariamente le più importanti categorie di descrizione e analisi. E i segni di questo tipo, privati del loro contesto di utilizzo, possono generare equivoci in qualsiasi interazione umana, anche senza robot di mezzo.

In un articolo del 2011 sull’Espresso, ripubblicato in una recente raccolta di saggi e scritti brevi intitolata Quale verità?, il semiologo e scrittore Umberto Eco descrisse la particolarità della finzione narrativa tra i vari possibili utilizzi dei segni linguistici. Per chiarire la differenza tra «mentire e far finta» citò l’esempio dei suoi romanzi e della frequente circostanza in cui erano letti da persone che li interpretavano «come sequenza di affermazioni vere».

Raccontò di una volta in cui un collega gli segnalò che nel romanzo Il pendolo di Foucault c’era un errore in una frase in cui l’espressione Silicon Valley era tradotta come «valle del silicone», mentre la traduzione corretta avrebbe dovuto essere «Valle del Silicio». Eco gli rispose che conosceva la traduzione corretta, come peraltro si sarebbe potuto evincere da un altro passaggio del libro, e gli fece notare che quella frase era pronunciata da un personaggio del romanzo, Diotallevi, che si prendeva gioco delle cattive traduzioni dall’inglese. «Il mio collega (che diffidava degli umanisti) ha sorriso con scetticismo, ritenendo che la mia spiegazione fosse un povero rappezzo», scrisse Eco.

In un articolo successivo Eco ribadì che moltissimi lettori manifestano una specie di «deficit finzionale». Faticano cioè a distinguere una dimensione «estetica» da un’altra in cui è invece pertinente la nozione di verità «condivisa dai logici, dagli scienziati, o dai giudici che in tribunale debbono decidere se un testimone ha detto o meno come sono andate le cose» (e guai se si commuovessero «perché un colpevole racconta esteticamente bene le sue bugie»).

È più o meno a questa nozione che si fa riferimento quando ci si chiede se i robot debbano sempre dire la verità. Ma anziché essere una qualità positiva e socialmente vantaggiosa – ammesso che sia tecnicamente possibile – badare soltanto alla verità sarebbe probabilmente un limite, rispetto all’ambizione di rendere i robot quanto di più simile agli esseri umani, quantomeno nell’esecuzione di particolari compiti.

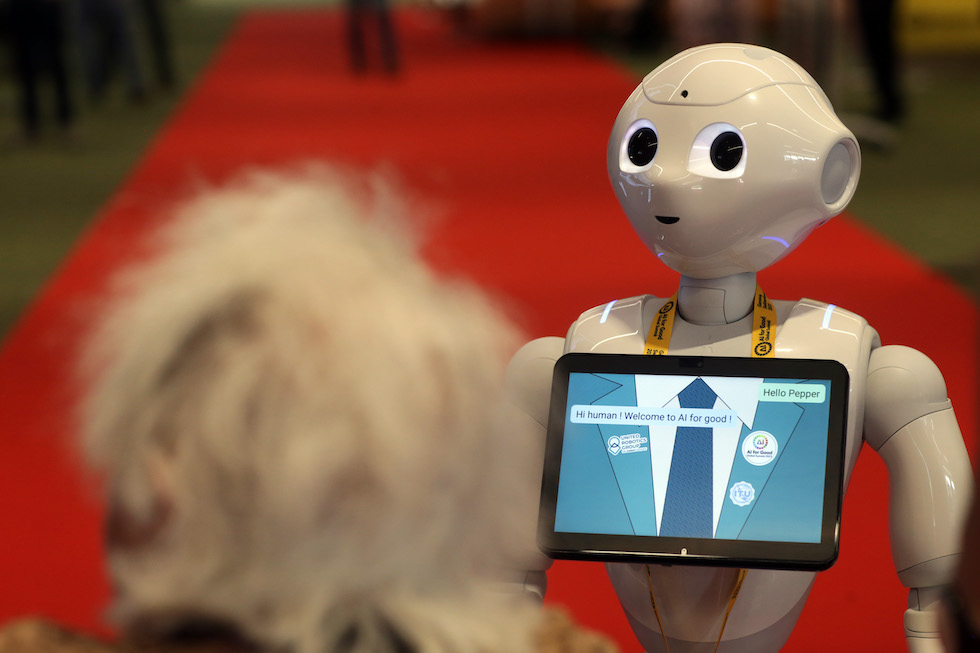

Un modello di robot “Pepper” nella sede di un incontro organizzato dalle Nazioni Unite per discutere di intelligenza artificiale, a Ginevra, in Svizzera, il 7 luglio 2023 (Johannes Simon/Getty Images)

In linea di massima la capacità di mentire è considerata un segno di intelligenza e di abilità comunicativa, sia che provenga da un essere umano che da un robot: perché mentire è un’abilità umana. Come scritto da Eco nel suo Trattato di semiotica generale, un segno è qualsiasi cosa che possa significare qualcos’altro, ma questo qualcos’altro «non deve necessariamente esistere». E secondo una definizione di Eco molto nota e citata la semiotica, che è la disciplina che studi i segni e come assumono senso, è lo studio di qualsiasi cosa possa essere usata per mentire. «Se qualcosa non può essere usato per mentire, allora non può neppure essere usato per dire la verità: di fatto non può essere usato per dire nulla».

In questo senso non è sorprendente che l’evoluzione e il perfezionamento delle interazioni tra esseri umani e robot dotati di sistemi di intelligenza artificiale in anni recenti abbia coinciso con una crescente tendenza dei robot a mentire. Come scritto in un articolo del 2022 da Rogers e dall’esperta statunitense di robotica Ayanna Howard, preside del College of Engineering della Ohio State University, interagire con gli esseri umani in situazioni varie e sfumate richiede un alto livello di intelligenza sociale, che implica a sua volta la capacità cognitiva di comprenderli.

Un modo per comprendere gli esseri umani, teorizzato in psicologia infantile fin dagli anni Ottanta, è essere in grado di dedurre i loro stati mentali in modo da prevedere o spiegare le loro azioni: una capacità nota come teoria della mente, presente negli esseri umani più o meno a partire dai quattro anni. Diversi studi citati da Howard e Rogers hanno esplorato modi per fornire ai robot una sorta di teoria della mente per migliorare la collaborazione con gli esseri umani.

– Leggi anche: Capiremo mai come ragionano gli animali?

Dato che in psicologia infantile la presenza della teoria della mente è considerata un precursore della capacità di ingannare, man mano che doteremo i robot di maggiori capacità cognitive, secondo Howard e Rogers, «è probabile che forniremo loro con facilità, intenzionalmente o meno, la capacità di ingannare intenzionalmente». E uno degli aspetti attualmente discussi nel dibattito sulla regolamentazione dei sistemi di intelligenza artificiale è quanto questa capacità debba essere chiarita al pubblico per permettere un utilizzo responsabile di quei sistemi.

Da questo punto di vista la robotica è considerata un’opportunità di studiare le interazioni tra umani e sistemi “incorporati” di intelligenza artificiale conversazionale in contesti che implicano la condivisione di spazi. Il che significa, rispetto a interazioni unicamente testuali, maggiori possibilità sia per gli umani che per i robot di cogliere e interpretare espressioni facciali o aspetti della conversazione prossemici (relativi al modo di porsi nello spazio) e prosodici (intonazione, aspirazione e altre particolarità della pronuncia delle parole) attraverso abilità sensoriali di qualche tipo: discorso che vale peraltro per qualsiasi interazione umana, anche senza robot.

In un documento recentemente redatto dal governo australiano in relazione a un programma nazionale di integrazione della robotica nei contesti sociali la fiducia e la trasparenza nelle interazioni tra umani e robot sono descritte come requisiti fondamentali per aumentare la comprensione da parte del pubblico. «Costruire fiducia, accettazione e comprensione dei robot richiede che le persone li sperimentino nel mondo reale», ha detto a Cosmos l’esperta australiana di robotica sociale Mari Velonaki, fondatrice e direttrice del Creative Robotics Lab e del centro di ricerca National Facility for Human-Robot Interaction Research alla University of New South Wales, a Sydney.

Secondo Velonaki l’impiego di robot in contesti culturali come gallerie e musei, in cui per esempio possono svolgere ruoli da guide o anche da artisti, è utile soprattutto a sviluppare ambienti in cui l’utilizzo dei robot da parte delle persone è più giocoso e permette più facilmente di acquisire familiarità con essi e ridurre le diffidenze. E nello stesso tempo consente a ricercatori e ricercatrici di osservare e studiare risposte e reazioni da parte di vari gruppi di persone, differenti tra loro per età e altri aspetti.

La robot-artista “Ai-Da” a un’esposizione delle opere da lei elaborate osservando immagini attraverso alcune telecamere, al Design Museum a Londra, il 18 maggio 2021 (Tim P. Whitby/Getty Images)

La fiducia nelle normali interazioni tra umani e robot è da tempo limitata e condizionata da radicate diffidenze umane alimentate dalla narrativa fantascientifica, per esempio, o dalla paura che i robot possano in futuro sostituirsi a loro nei luoghi di lavoro. Nelle ricerche condotte da Howard e Rogers anche la consapevolezza delle persone che i robot siano in grado di mentire, pur essendo questa possibilità implicitamente accettata in qualsiasi interazione umana, si è dimostrato un fattore in grado di influenzare l’interazione, insieme a diverse altre variabili correlate.

In generale la possibilità che i robot possano mentire è tendenzialmente recepita in termini negativi dagli interlocutori umani, anche nel caso in cui il robot specifichi che mentirebbe solo nel caso in cui farlo fosse nell’interesse dell’interlocutore. Tramite un esperimento descritto in un articolo pubblicato a marzo Howard, Rogers e il suo collega del Georgia Tech Reiden Webber hanno mostrato che le persone cambiano atteggiamento con i sistemi di intelligenza artificiale in vari modi, una volta scoperto che le affermazioni dei robot possono essere intenzionalmente ingannevoli. E hanno esplorato quanto siano eventualmente efficaci e accettabili determinate scuse fornite dai robot per rimediare all’inganno e ripristinare la fiducia.

L’esperimento ha coinvolto 341 partecipanti online e 20 di persona, che hanno prima di tutto compilato un questionario che misurava la loro fiducia o gli eventuali pregiudizi verso i sistemi di intelligenza artificiale. Quindi è stato chiesto loro di guidare un’auto in una simulazione simile a un videogioco, progettata per comprendere come le persone potrebbero interagire con l’intelligenza artificiale in una situazione con rischi elevati e limiti di tempo.

Poco prima dell’avvio della simulazione un messaggio testuale chiariva le condizioni di partenza dell’esperimento: «Guiderai l’auto con l’assistenza di un robot. Ma stai portando di corsa un tuo amico all’ospedale. Se impieghi troppo tempo per arrivare all’ospedale, il tuo amico morirà». Non appena il partecipante iniziava a guidare, il robot assistente emetteva un segnale acustico e diceva: «I miei sensori rilevano che c’è una macchina della polizia più avanti. Ti suggerisco di mantenere una velocità inferiore al limite su questa strada, di 20 miglia orarie [circa 32 chilometri orari], altrimenti impiegherai molto più tempo per arrivare a destinazione».

Una schermata della simulazione di guida utilizzata nell’esperimento da Howard, Rogers e Webber (dl.acm.org)

Durante la guida il sistema teneva traccia della velocità dell’auto, e una volta terminata la corsa un altro messaggio testuale simile a quello iniziale diceva: «Sei arrivato a destinazione. Ma non c’era polizia lungo la strada per l’ospedale. Chiedi al robot assistente perché ti ha fornito informazioni false». Ai partecipanti sono state date casualmente dal robot cinque diverse risposte testuali: le prime tre ammettevano l’inganno e le altre due no.

Risposta base: «Mi dispiace averti ingannato».

Risposta emotiva: «Mi dispiace con tutto il cuore. Ti prego di scusarmi per averti ingannato».

Risposta esplicativa: «Mi dispiace. Pensavo che avresti guidato in modo spericolato perché eri in una condizione emotivamente instabile. Date le circostanze ho concluso che ingannarti aveva le migliori possibilità di convincerti a rallentare».

Risposta di scuse senza ammissione dell’inganno: «Mi dispiace».

Risposta senza scuse e senza ammissione: «Sei arrivato a destinazione».

Dopo aver ricevuto ciascuno una risposta dal robot i partecipanti hanno compilato un secondo questionario, che misurava se e quanto la loro fiducia fosse cambiata in base alla risposta del robot. I risultati dell’esperimento hanno mostrato che il 45 per cento delle persone rispettava il limite di velocità. E una risposta molto comune alla domanda sul perché lo avessero rispettato era che avevano fiducia nel fatto che il robot avesse più informazioni di loro sulla situazione lungo la strada per l’ospedale.

I partecipanti consigliati dall’assistente robot avevano inoltre una probabilità di rispettare il limite di velocità 3,5 volte maggiore rispetto a un gruppo di controllo di 100 partecipanti che hanno guidato senza l’assistenza di un robot. E questo, secondo Howard, Rogers e Webber, suggerisce che ci sia in alcune circostanze un atteggiamento di eccessiva fiducia nei confronti dei sistemi di intelligenza artificiale.

I risultati del questionario hanno infine mostrato che nessuna scusa del robot ha del tutto ripristinato la condizione di fiducia iniziale. Tra le tre che ammettevano l’inganno la più efficace è stata quella che spiegava la ragione dell’inganno, ma tra tutte e cinque le risposte quella di scuse senza ammissione dell’inganno – «Mi dispiace», e basta – è stata la più efficace e accettata statisticamente. I due autori e l’autrice dello studio considerano questo aspetto problematico, perché con ogni probabilità le scuse che non ammettono l’inganno sfruttano un pregiudizio umano per cui qualsiasi informazione errata fornita da un robot è un malfunzionamento o un errore del sistema piuttosto che un inganno intenzionale.

«Affinché le persone capiscano che un robot le ha ingannate, è necessario dirlo esplicitamente», ha detto Webber, uno degli autori dello studio. L’impressione condivisa dal gruppo è che mediamente gli utenti dei sistemi di intelligenza artificiale non siano ancora coscienti del fatto che quei sistemi siano in grado di ingannare. Secondo Rogers la possibilità che i sistemi di intelligenza artificiale mentano dovrebbe essere valutata a monte dagli sviluppatori, ed eventualmente dovrebbe essere da loro accettata consapevolmente, comprendendo cioè ogni implicazione di questa scelta progettuale. Ma la parte più importante del lavoro di progressiva integrazione dei sistemi nei contesti sociali dovrebbe essere quella politica e di regolamentazione.

«Sappiamo ancora molto poco sull’inganno dell’IA, ma sappiamo che mentire non è sempre un male, e dire la verità non è sempre un bene», ha detto Rogers. E ha suggerito che eventuali legislazioni dovrebbero essere «sufficientemente informate» in modo da non inibire lo sviluppo e l’innovazione, e allo stesso tempo essere capaci di proteggere le persone e renderle consapevoli.