La moderazione online affidata agli utenti

Tumblr vuole rendere più collaborativa la gestione dei contenuti "per adulti" e non è l'unica piattaforma ad andare in questa direzione

di Viola Stefanello

Qualche giorno fa Tumblr, una piattaforma un tempo definita di “microblog” e oggi a sua volta una sorta di social network, ha annunciato una nuova funzionalità, le cosiddette “community labels” (letteralmente “etichette della comunità”), ovvero dei tag che permettono a chi pubblica un nuovo contenuto di avvertire gli altri utenti se una foto, un video, un testo o una gif contengono riferimenti alla violenza, alle droghe o all’alcol, al sesso o ad altri “contenuti per adulti”.

La notizia ha ottenuto attenzioni perché, in un primo momento, sembrava che segnalasse un cambio di passo dell’azienda. Nel 2018 infatti Tumblr aveva bandito i contenuti pornografici, che costituivano una percentuale molto significativa di tutti quelli presenti sul sito. Il CEO dell’azienda a cui appartiene Tumblr, Matt Mullenweg, ha spiegato che le politiche adottate dalla piattaforma nel 2018 «sono ancora in vigore, ma stiamo lavorando per renderle più aperte e sensate». L’innovazione di Tumblr fa parte di una serie di recenti tentativi fatti dai social network nell’ambito della moderazione dei contenuti, una questione a lungo dibattuta e a cui sembra impossibile trovare una soluzione che soddisfi tutti.

Ogni giorno su Internet vengono pubblicati miliardi di post, video, foto e commenti: molti di questi sono innocui, ma altri sono oggetto di controversie che interessano non solo chi gestisce il sito su cui compare il contenuto, ma talvolta anche la legge, i governi e la società civile. In passato, l’assenza di una sufficiente moderazione ha causato serie conseguenze per gli utenti più vulnerabili, online e offline, danneggiando al contempo la reputazione delle aziende tecnologiche e portando una maggiore attenzione sul tema da parte dei legislatori di diversi paesi. Per questo, molte aziende hanno introdotto una moderazione più rigida, trovandosi però a dover fare i conti con molti utenti, che usando i social network per scopi artistici, di divulgazione, di lavoro o anche semplicemente di espressione personale, hanno cominciato a lamentare l’eccessivo e indiscriminato controllo delle piattaforme.

Nel caso di Tumblr, il principale problema relativo alla moderazione dei contenuti è emerso nel 2018, quando il Congresso statunitense ha passato due leggi che rendono molto difficile ospitare contenuti sessualmente espliciti online. Lo stesso anno, Tumblr vietò sia i contenuti esplicitamente pornografici che quelli che rappresentavano nudi e quelli in cui si vedevano donne con i capezzoli scoperti, ma non quelli in cui il nudo serviva uno scopo «artistico, educativo, giornalistico o politico». Da allora però il sito non è più stato lo stesso. Secondo un’analisi di Mashable, nei dodici mesi successivi Tumblr ha perso un terzo dei propri utenti attivi, ovvero circa 150 milioni di persone. Se, prima del divieto, Tumblr era ricco di meme e spunti per gli utenti delle altre piattaforme (un po’ come TikTok oggi), dal 2018 ha raramente fatto parlare di sé.

L’introduzione delle “community labels” ha brevemente destato l’attenzione di chi sperava in un cambiamento nelle politiche relative alla pornografia. La nuova funzione di filtraggio permette di non eliminare del tutto i contenuti per adulti, ma di far sì che rimangano nascosti agli utenti sotto i 18 anni e che tutti gli altri utenti possano scegliere se vederli o no. Una volta etichettati i post per adulti saranno sfocati o nascosti del tutto nella dashboard degli utenti, a seconda delle proprie impostazioni.

Nell’annunciare la novità Mullenweg ha scritto che si tratta di «un’opportunità per lavorare verso un’esperienza più ricca e colma di sfumature» su Tumblr. Tra gli esempi che ha dato di contenuti che ora sarebbero accettabili sul sito, a patto che siano etichettati come “per adulti”, ci sono «una fan art della tua coppia di personaggi immaginari preferiti che stanno vivendo un momento di intimità, una GIF che mostra l’abuso di sostanze di Rue di Euphoria, un trailer che mostra delle scene vivide da un film di guerra e delle illustrazioni esplicite di 50 sfumature di grigio».

Nella sua newsletter Garbage Day, il giornalista Ryan Broderick ha fatto notare che l’introduzione di sistemi di filtraggio come quelli introdotti da Tumblr, che permettano agli utenti di decidere quali tipi di contenuti vogliono o meno vedere, sono uno sviluppo intelligente in un campo come quello della moderazione su larga scala.

Negli ultimi anni, infatti, le grandi aziende tech hanno faticato a trovare un approccio che permetta di venire incontro alle sensibilità e alle necessità molto diverse delle milioni di persone che convivono quotidianamente sulle loro piattaforme. Il fatto che moltissimi minori usino i social network ha anche portato un crescente scrutinio nei confronti di queste aziende, a cui viene chiesto di assicurarsi che i più giovani non entrino a contatto con moltissimi contenuti adatti ad un pubblico adulto, come appunto quelli a sfondo sessuale.

Finora, piattaforme come Facebook, Instagram e Tumblr hanno risposto con un approccio grossolano, limitando il tipo di contenuti accettati sulla piattaforma e affidando il loro riconoscimento in larga parte a sistemi automatizzati di moderazione, che però fanno ancora errori piuttosto rudimentali.

Nel loro Manifesto per social media sex-positive, pubblicato a fine agosto, le ricercatrici Zahra Stardust, Emily van der Nagel, Katrin Tiidenberg, Em Coombes, Jiz Lee e Mireille Miller-Young hanno criticato questa strategia, scrivendo che «la moderazione dei contenuti dovrebbe essere il risultato del coinvolgimento della comunità, in un sistema in cui i creator etichettano e classificano i propri contenuti senza essere penalizzati e il pubblico sa di potersi fidare dei tag». E che «le piattaforme dovrebbero permettere agli utenti di avere controllo su ciò che vedono e quando, dando loro l’opportunità di accettare e rifiutare contenuti specifici».

Negli ultimi tempi, diverse aziende hanno testato un approccio più granulare, che permetta agli utenti di avere un maggiore controllo sulla propria esperienza online, ma non sempre con risultati significativi.

Su Instagram da poco più di un anno c’è la possibilità di decidere se si vogliono vedere più o meno “contenuti sensibili” nella sezione Esplora della piattaforma, ma non c’è ancora modo per gli utenti di etichettare volontariamente un proprio contenuto come sensibile o meno. Quindi tutte le decisioni relative alla classificazione dei contenuti sono ancora in mano all’azienda.

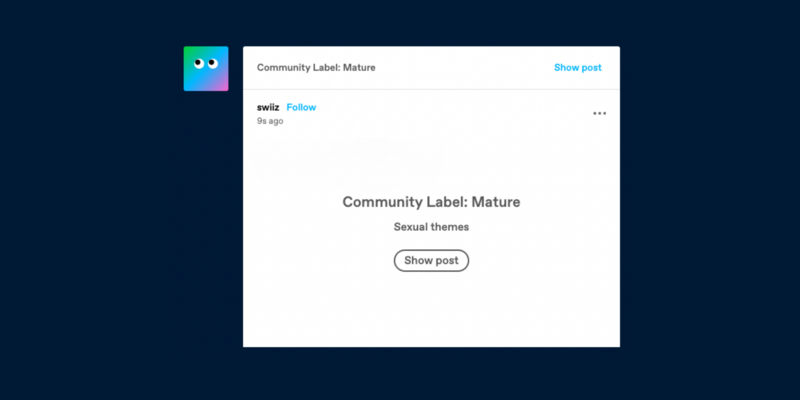

Su Twitter, già dal 2018 alcuni contenuti – come quelli che mostrano nudità o violenza – vengono riconosciuti come potenzialmente sensibili dall’algoritmo di moderazione e nascosti automaticamente dietro a un avviso, in modo che sia l’utente a decidere se vuole vedere l’immagine o meno. Di recente, però, l’azienda ha introdotto due nuove funzionalità che offrono più controllo agli utenti: ha cominciato a permettere a chiunque di etichettare un proprio contenuto come potenzialmente sensibile e di comunicare, nelle proprie impostazioni, se vogliono che la piattaforma filtri o meno i contenuti sensibili per loro.

La maggior parte dell’innovazione in materia, però, non arriva dalle grandi piattaforme, ma da sviluppatori esterni: è il caso di BlockParty, che rende più facile e veloce riconoscere e bloccare gli utenti più molesti su Twitter e permette all’utente di decidere se interagire o meno con utenti con cui non ha nessun collegamento in comune.