“Alexa, clona la voce di nonna”

Una nuova e per molti inquietante funzione sperimentale dell'assistente vocale di Amazon permette di imitare qualsiasi persona, anche quelle morte

Amazon sta lavorando a una nuova funzione che permette ad Alexa, la sua assistente vocale, di parlare imitando la voce delle proprie persone care, anche se queste sono morte. Il sistema è stato presentato questa settimana nel corso di MARS, la conferenza annuale con cui l’azienda presenta le proprie novità, e per ora è in fase di sperimentazione. La possibilità di far parlare le persone morte, con un sintetizzatore vocale che le imita, ha portato a qualche critica e perplessità, nonostante non sia la prima volta che vengono sviluppati sistemi digitali per farlo.

Nel corso della presentazione, uno dei responsabili dell’intelligenza artificiale alla base di alcune funzioni di Alexa, Rohit Prasad, ha mostrato il video di un bambino che chiede all’assistente vocale di leggergli una favola con la voce di sua nonna. Prasad ha detto che l’aggiunta di «caratteristiche umane» ai sistemi di intelligenza artificiale sarà sempre più importante, e specialmente «in questi tempi con una pandemia in corso, quando molti di noi hanno perso qualcuno di caro».

Prasad ha poi aggiunto che: «Mentre le intelligenze artificiali non possono eliminare il dolore per una perdita, possono sicuramente rendere duraturo il loro ricordo». Amazon non ha fornito indicazioni su quando e in quali circostanze il sistema sarà messo a disposizione di chi utilizza Alexa sui propri smartphone, oppure tramite uno dei vari dispositivi per la casa della serie Echo.

Ad Alexa è sufficiente ascoltare meno di un minuto di una registrazione contenente la voce che si desidera clonare. Stando alla dimostrazione, il risultato finale è piuttosto realistico, ma molti aspetti della nuova funzionalità devono essere ancora chiariti. Prasad non ha spiegato se ci saranno particolari limitazioni, per esempio per evitare che vengano invece clonate voci di persone che non hanno dato il loro consenso e che potrebbero essere sfruttate nel migliore dei casi per qualche scherzo o, nel peggiore, per truffe.

Il sistema cui sta lavorando Amazon non è certo il primo a offrire la possibilità di produrre voci sintetiche che imitano quelle di altre persone. Negli ultimi anni i progressi nello sviluppo di algoritmi e intelligenze artificiali hanno reso possibile la clonazione della voce, così come la produzione di video in cui il viso di una persona può essere digitalmente sovrapposto a quello di un’altra (deepfake).

Gli “audio deepfake” sono impiegati in maniera crescente nelle produzioni televisive e cinematografiche, nel settore dei videogiochi e in quello dei podcast. Nel caso dei podcast, alcuni software permettono di modificare le frasi pronunciate da chi le ha registrate, per esempio nel caso in cui abbia sbagliato la pronuncia di una parola o commesso un errore di qualche altro tipo. Gli interventi riguardano di solito pochi secondi di parlato, mentre nel caso di Alexa si tratterebbe di una sintesi vocale molto più estesa ed elaborata.

La possibilità di clonare le voci è da qualche anno al centro di un ampio dibattito, soprattutto sui risvolti etici derivanti dall’impiego di queste tecnologie. Se ne era parlato molto lo scorso anno, in seguito alla scelta di ricreare per un film-documentario la voce dello chef e divulgatore culinario Anthony Bourdain, morto nel 2016.

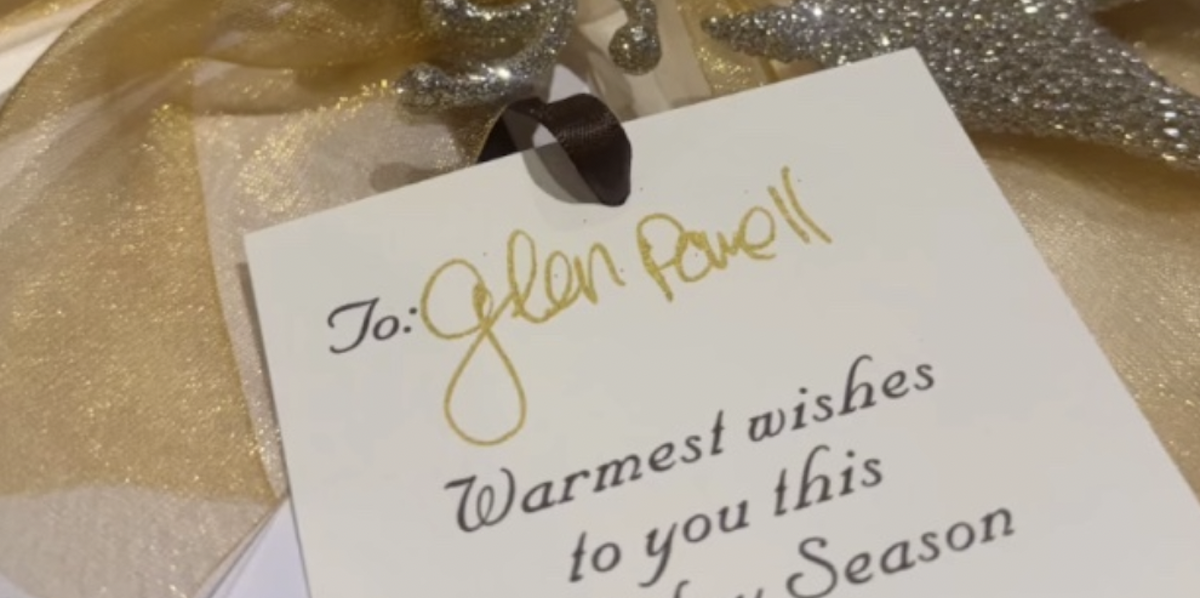

Più di recente, si è parlato di opportunità e rischi della sintesi vocale in occasione dell’uscita del film Top Gun: Maverick, nel quale recita anche Val Kilmer, l’attore statunitense che dopo un intervento chirurgico del 2015 dovuto a un cancro alla gola non riesce più a parlare come prima. La sua voce era stata ricostruita digitalmente da una startup inglese, Sonantic, proprio su richiesta dell’attore suscitando molte domande sull’opportunità di questa tecnica, anche al di fuori delle produzioni cinematografiche.

Nel caso di Kilmer, Sonantic aveva estratto le tracce audio con la sua voce da vari film, utilizzandola poi per istruire il sintetizzatore vocale. Grazie a questo lavoro erano state prodotte 40 varianti della voce, tra le quali Kilmer aveva scelto quella che lo convinceva di più. Il processo era stato quindi elaborato e non paragonabile a quello molto più rapido, e con pochi secondi della voce originale da impiegare come campione, sviluppato da Amazon.

Soprattutto nel caso della sintesi vocale, questi sistemi sono comunque ancora poco diffusi tra i non addetti ai lavori: la maggior parte delle soluzioni più accurate richiede un minimo di conoscenze nella programmazione e non è facilmente accessibile ai meno esperti. La funzione di Alexa potrebbe cambiare notevolmente le cose, mettendo a disposizione di milioni di persone uno strumento piuttosto semplice e immediato per clonare la voce di qualcuno.

Nel caso di un personaggio famoso, la clonazione della voce può rivelarsi utile e tutto sommato innocua, se per esempio viene realizzata nell’ambito di un prodotto chiaramente di fiction. Lo scorso anno per una puntata dei Simpson era stata per esempio clonata la voce di Marcia Wallace – la doppiatrice di Edna Krabappel (la signora Caprapall nella versione italiana) – morta nel 2013. In un altro caso era stata ricreata la voce del presidente statunitense Richard Nixon a scopo educativo, per fargli leggere il famoso discorso “In caso di disastro lunare”, che avrebbe dovuto pronunciare nel caso di un incidente durante la missione dell’Apollo 11, la prima a portare esseri umani sulla Luna.

Clonare la voce di persone non famose porta con sé varie implicazioni aggiuntive. Per usare una voce di una persona morta in un prodotto destinato al pubblico, come un film o una serie tv, viene solitamente chiesto il consenso ai familiari dell’individuo defunto, processo che consente di avere un minimo di garanzie sul tipo di impiego che ne sarà fatto. Nel caso di un uso privato, è molto più difficile stabilire quali siano i confini e soprattutto evitare che una registrazione vocale diventi la base per far dire a una persona, viva o morta che sia, qualsiasi cosa con un deepfake audio.

Come hanno fatto notare vari osservatori, la presentazione di Amazon aveva alcuni elementi tipici di molti annunci delle aziende tecnologiche: una grande enfasi sul risultato raggiungibile e una scarsissima valutazione delle implicazioni pratiche ed etiche dell’innovazione proposta. Come ha scritto l’ex direttore del sito di tecnologia Gizmodo UK, James O’Malley: «Sono totalmente ammirato dal fatto che questa idea sia passata per le mani di così tante persone ad Amazon – dirigenti, sviluppatori, pubbliche relazioni – e che nessuno si sia fermato per chiedersi se fosse effettivamente una buona idea».

Rachel Tobac, responsabile di un’azienda che si occupa di sicurezza e informatica di San Francisco, ha sollevato numerosi dubbi sulla nuova funzionalità di Alexa: «Se un criminale informatico può ricreare facilmente e in modo credibile la voce di un’altra persona con un piccolo campione vocale, potrà usare quella voce clonata per fingere di essere qualcun altro. Potrebbe in questo modo far credere a chi l’ascolta di essere quella persona, cosa che potrebbe portare a frodi, furto di dati, di account online e di molto altro».

Ciò che ha ricevuto maggiori attenzioni è comunque la possibilità che vengano prodotte facilmente voci sintetiche senza il diretto consenso delle persone interessate. È un problema che riguarda sia le persone morte, che difficilmente avranno messo in programma di dare disposizioni sul ricorso a queste pratiche, sia per chi è ancora vivo e potrebbe scoprire di avere un amico che gli ha clonato la voce per fargli uno scherzo, mandare qualche messaggio vocale a nome suo ai contatti in comune o per qualche altro uso inquietante.

In seguito alle grandi attenzioni suscitate dalla presentazione, Amazon ha chiarito che il sistema non è comunque stato sviluppato espressamente per le persone morte. Lo stesso Prasad, il dirigente dell’azienda che aveva presentato la nuova funzionalità, ha provato a rendere meglio l’idea sugli scopi dell’iniziativa: «Non riguarda le persone che non sono più con te. Ma riguarda, per esempio, tuo figlio quando vorrebbe ascoltare la voce di sua nonna ma non può farlo, perché è assente. Personalmente vorrei poterlo fare».