La vita infernale dei moderatori di Facebook

Un lungo e discusso articolo di “The Verge” ha raccontato i traumi e le fatiche di chi per lavoro decide cosa può rimanere sul social network e cosa no

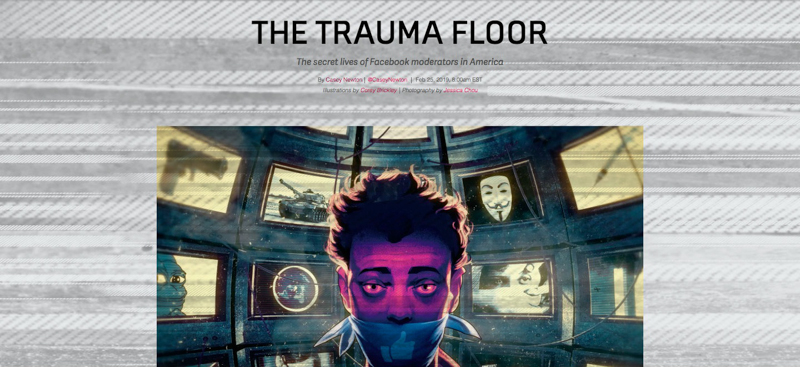

Il sito di tecnologia The Verge ha pubblicato un lungo articolo in cui ha raccontato la dura vita quotidiana dei moderatori dei contenuti di Facebook, e più precisamente di quelli che lavorano per Cognizant, una società a cui Facebook appalta una parte dell’enorme lavoro richiesto dalla revisione giornaliera dei contenuti segnalati o che potenzialmente violano le linee guida del social network. Casey Newton, che ha scritto l’articolo, ha parlato con una decina di dipendenti o ex dipendenti di Cognizant, che mantenendo l’anonimato hanno raccontato di condizioni di lavoro estremamente stressanti, sia per gli orari stringenti e soprattutto per i contenuti impressionanti e violenti da visionare continuamente. La maggior parte delle persone con cui ha parlato Newton non sono rimaste a Cognizant più di un anno; diversi hanno raccontato di aver avuto conseguenze gravi sulla propria salute mentale.

Cognizant ha sede a Phoenix, in Arizona, e ci lavorano circa 1.000 persone. Newton scrive che in totale i moderatori sparsi per il mondo sono 15.000, che coprono tutto l’arco della giornata e lavorano da 20 sedi, padroneggiando un totale di 20 lingue. Appaltare questo lavoro a società esterne riduce di molto i costi della forza lavoro: se un dipendente di Facebook guadagna in media 240mila euro all’anno, un moderatore di Cognizant guadagna meno di 30mila dollari. Facebook, intanto, continua a passarsela bene: nell’ultimo trimestre ha dichiarato 6,9 miliardi di dollari di profitti, il 61 per cento in più dell’anno precedente, su 16,9 miliardi di ricavi totali.

Newton ha dovuto mantenere l’anonimato dei moderatori intervistati perché per contratto firmano un accordo di riservatezza, ufficialmente per evitare che gli utenti a cui vengono eliminati i contenuti si rivalgano personalmente e per impedire la divulgazione di dati sensibili. Questo significa anche che è più difficile che trapelino racconti sulle condizioni di lavoro di questi moderatori, come quelli raccolti da Newton.

Il lavoro dei dipendenti di Cognizant, nel concreto, è quello di visionare uno dopo l’altro contenuti pubblicati su Facebook – commenti, post, foto, video – che siano stati segnalati per aver potenzialmente violato le linee guida pubbliche. Il problema principale per queste persone – non l’unico, come vedremo – sono quindi le cose che altre persone in tutto il mondo decidono di pubblicare su Facebook. Il mestiere di moderatori comporta infatti passare le giornate a leggere molte cose aggressive, violente, razziste e che incitano all’odio, ma non solo: i racconti si soffermano soprattutto sulle foto e i video violenti, quelli complottisti, quelli offensivi, razzisti o contenenti pornografia. Questa esposizione quotidiana ha spesso delle brutte conseguenze.

Una donna di nome Chloe ha raccontato della sua esperienza durante uno dei corsi preparatori al lavoro di moderatore. Per uno degli ultimi test, dovette vedere un video di cui non sapeva nulla davanti a una commissione, e decidere cosa fare. Il video mostrava un uomo ucciso con molte coltellate: lei disse correttamente che era da rimuovere, tornò al suo posto ma poi dovette uscire dalla stanza per mettersi a piangere. Dopo essersi calmata in bagno, tornò nella stanza: un altro aspirante moderatore stava commentando un video che mostrava delle persone uccise da un drone. Chloe crollò di nuovo, uscendo dalla stanza. Un supervisore andò a consolarla in bagno, spiegandole che una volta operativa avrebbe potuto usare dei trucchi per impressionarsi meno, tipo mettere in pausa il video o guardarlo senza audio.

Un altro dipendente, identificato come Randy, ha raccontato un’esperienza simile: rimase a Cognizant per circa un anno, ma si porta ancora dietro un video che gli toccò vedere. Anche quello mostrava un accoltellamento, con protagonista un uomo della sua età: mentre moriva, invocava sua madre. Il video turbò moltissimo Randy, che sviluppò una fobia per i coltelli. L’uomo fu toccato anche da un altro aspetto comune a diversi dipendenti della società, secondo quanto raccontato a Newton: vedere continuamente video complottisti, giorno dopo giorno per ore, finì con l’influenzarlo. Oggi per esempio crede che gli attentatori della strage di Las Vegas del 2017 furono più di uno.

Nel suo ufficio c’erano persone che furono convinti dalle teorie “terrapiattiste”, e altri che dopo l’esperienza da moderatori sono scettici verso certi aspetti delle ricostruzioni storiche sull’Olocausto o che non credono che quello dell’11 settembre 2001 sia stato un attentato. A Randy è stato diagnosticato un disturbo post-traumatico da stress e un disturbo d’ansia. Dorme con una pistola sotto il cuscino, con la quale controlla la sua casa ogni mattina. Non è l’unica storia del genere che emerge dal racconto di Newton. L’anno scorso, per esempio, un ex moderatore di Facebook che lavorava per l’azienda Pro Unlimited fece causa al social network sostenendo che il suo lavoro l’avesse traumatizzato psicologicamente, provocandogli un disturbo post-traumatico da stress.

Ma il lavoro di moderatore per Facebook è stressante anche per un altro problema, spiega Newton. L’ambiente e i ritmi lavorativi dei dipendenti di Cognizant sono molto diversi da quelli di Facebook, un’azienda che ha costruito una parte importante della sua immagine sul proclamato benessere dei suoi dipendenti e sugli spazi di lavoro accattivanti e vivaci. Newton spiega che gli uffici di Cognizant non sono tetri né angusti, ma le condizioni dei dipendenti sono tutto meno che rilassate: ciascuno ha due pause da 15 minuti al giorno, più una da 30 minuti per il pranzo.

I pochi bagni a disposizione sono sempre affollati e i dipendenti hanno raccontato che finiscono per dedicare una decina di minuti delle proprie pause a raggiungerli, fare la coda e tornare alla propria postazione. Ogni dipendente ha poi una pausa giornaliera di 9 minuti chiamata “di benessere”: serve in teoria per staccare brevemente dal computer dopo essersi occupati di contenuti particolarmente traumatici. I dipendenti musulmani la usavano spesso per pregare, finché – hanno raccontato dei colleghi – è stato chiesto loro di smettere. Altri la usavano per andare in bagno in momenti in cui era meno affollato.

Per una paga di circa 15 dollari all’ora, 4 in più del minimo salariale in Arizona, i moderatori si occupano di centinaia di contenuti al giorno. Miguel, uno che ha parlato con Newton, ha spiegato che a regime riesce a dedicare soltanto una trentina di secondi per ciascuno. Ma il lavoro non è affatto semplice. Si tratta, infatti, di applicare un lungo, complesso e spesso ambiguo sistema di regole, che oltretutto cambia settimanalmente. I criteri usati nella moderazione sono molti: la base sono le linee guida pubbliche di Facebook, che vengono integrate da un altro documento interno di 15.000 parole, che approfondisce nel dettaglio alcune questioni. Una terza fonte su cui basare gli standard della moderazione, spiega Newton, sono le discussioni tra gli stessi moderatori, soprattutto quando ci sono notizie che si sviluppano pian piano accompagnate da video e immagini: discussioni che spesso però non finiscono con un consenso. È a questo punto che si inizia a salire la scala gerarchica dei supervisori, con la decisione finale che può arrivare dall’alto.

Facebook diffonde più o meno ogni due settimane degli aggiornamenti interni per le linee guida, ma in realtà ci sono aggiustamenti quotidiani. Questi vengono pubblicati su Workplace, che è una specie di Facebook per i dipendenti di Facebook: funziona a sua volta con un algoritmo che non ordina i post sulla timeline in ordine cronologico, ma con un sistema più complesso che tiene conto anche del numero di commenti e reazioni. Questo, hanno raccontato i dipendenti di Cognizant, significa che a volte i moderatori commettono degli errori perché si basano su comunicazioni ufficiali che vedono su Workplace ma che nel frattempo sono state sostituite da aggiornamenti più recenti, che però non compaiono in timeline.

Tutto questo si traduce, spiegano i dipendenti di Cognizant che hanno parlato con Newton, in una gran confusione. Anche perché, come sa chiunque frequenti i social network, spesso le linee guida non aiutano a capire il senso di un contenuto: serve che i moderatori conoscano il contesto in cui è stato pubblicato, o che colgano l’ironia o un certo tipo di umorismo. Applicando alla lettera gli standard, per esempio, una volta Facebook rimosse un passaggio della Dichiarazione di indipendenza americana che parlava di «indiani selvaggi».

Post come «le persone autistiche andrebbero sterilizzate» non violano gli standard perché l’autismo non è classificata come “caratteristica protetta” come il genere o l’etnia. «Gli uomini andrebbero sterilizzati» invece li vìola, così come «odio tutti gli uomini»; a differenza di «mi sono appena lasciata con il mio ragazzo, e odio tutti gli uomini» che invece non deve essere rimosso. Per i moderatori non si tratta solo di decidere se rimuovere o meno un contenuto, ma anche di selezionare correttamente la motivazione. Se la sbaglia, il suo punteggio di precisione ne risente. È una percentuale, e in teoria se scende sotto il 95 per cento il moderatore rischia il lavoro. A Cognizant, il punteggio medio è più basso.

A giudicare le decisioni dei moderatori sono dei supervisori con più esperienza: sui circa 1.500 contenuti giudicati settimanalmente da ciascun dipendente di Cognizant, ne vengono selezionati casualmente una cinquantina per essere valutati come campione. Una percentuale di questi contenuti passa poi per una seconda valutazione, fatta direttamente dai dipendenti di Facebook. Un moderatore può anche fare ricorso contro la valutazione di un suo superiore, dando luogo a episodi relativamente frequenti di conflitti e intimidazione, spiega Newton.

Per via del contatto costante con contenuti espliciti, macabri, offensivi o razzisti, e poiché i moderatori non possono parlarne fuori dal lavoro, i legami tra colleghi diventano molto forti molto in fretta, secondo le testimonianze date a Newton. I modi che ciascuno ha di sopportare questo tipo di lavoro sono diversi: a Cognizant è capitato che due persone venissero sorprese a fare sesso per le scale o in una saletta dedicata all’allattamento, mentre altri passano le pause a fumare marijuana per stordirsi. In generale, i dipendenti hanno raccontato che hanno sviluppato una specie di passione per le battute macabre e offensive, per via dell’esposizione quotidiana a contenuti di quel tipo.

Mentre scriveva l’articolo, Newton ha ovviamente contattato Facebook, che ha così organizzato una visita alla sede di Cognizant. Era la prima volta che un giornalista visitava uno di questi centri di moderazione. Il giorno prima, gli ha detto una fonte, erano stati appesi dei nuovi poster motivazionali. Newton ha parlato con cinque dipendenti, sempre alla presenza del loro capo: tutti hanno fornito testimonianze molto diverse da quelle raccolte anonimamente, descrivendo un lavoro spesso complicato e stancante, ma non traumatico o stressante. La maggior parte dei contenuti visionati, gli hanno detto, è poi tutto sommato innocuo: sfoghi degli utenti, e contenuti segnalati solo perché infastidivano qualcuno.

Dopo la pubblicazione del pezzo, Facebook ha pubblicato un post per spiegare di voler aumentare il controllo sulle condizioni contrattuali e lavorative dei moderatori assunti da aziende esterne. Lo stesso sito The Verge, però, ha spiegato che non ci sono vere indicazioni che l’annuncio di Facebook corrisponda a reali cambiamenti nel modo di gestire le società esterne, che secondo Sarah Frier di Bloomberg sono preferite da Facebook perché proteggono la società dalle potenziali cause legali dei moderatori. L’articolo di The Verge, poi non era nemmeno il primo a parlare delle condizioni di lavoro di questi centri: ne erano usciti su Wired, sul Guardian e su Motherboard.