L’etica dell’intelligenza artificiale

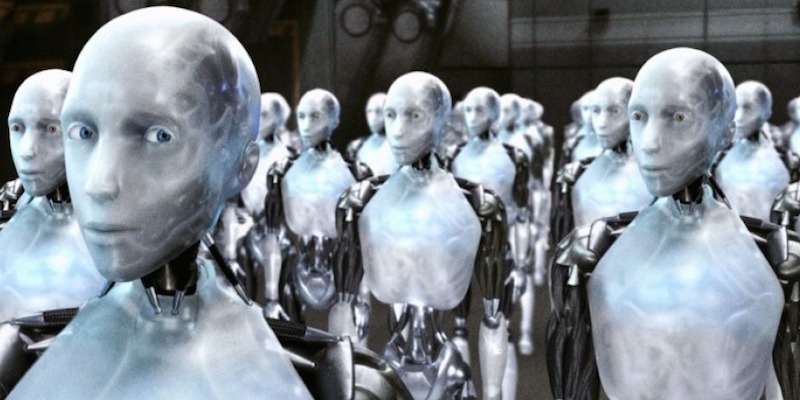

Più i computer e i robot diventeranno intelligenti e autonomi, più avremo bisogno di strumenti e soluzioni per assicurarci che facciano solo il nostro bene, ma sarà possibile?

Con lo sviluppo dell’intelligenza artificiale (AI) in numerosi campi di applicazione – logistica, trasporti e controlli di sicurezza, dalla realizzazione di opere d’arte alle traduzioni – si porranno sempre di più questioni etiche relative al nostro rapporto con le macchine. Da un lato bisognerà assicurarsi che le AI non siano dannose per gli esseri umani, dall’altro sarà necessario riflettere sulla morale delle stesse macchine. Le intelligenze artificiali del futuro saranno costruite in modo da raggiungere uno specifico obiettivo e potrà darsi che nel portare a termine il loro compito si trovino davanti a una scelta, anche piccola: per avere la sicurezza che non commettano errori, i loro programmatori dovranno prendere in considerazioni tutte le possibili implicazioni di una data scelta in un dato contesto e così prevedere possibili casi in cui le macchine potrebbero comportarsi in modo sbagliato dal punto di vista etico. Il più semplice degli esempi è quello delle automobili che si guidano da sole: cosa faranno quando dovranno decidere se investire una scolaresca o evitarla schiantandosi su un muro con gravi conseguenze per i passeggeri?

In realtà le questioni su cui esperti di robotica, filosofi e neuroscienziati hanno cominciato a riflettere – Deep Mind, una società di ricerca sui sistemi di intelligenza di proprietà di Google, ha creato insieme a Facebook, Amazon, IBM e Microsoft una “Partnership on Artificial Intelligence to Benefit People and Society” a questo scopo e in teoria ha al suo interno un comitato etico che riflette sulle implicazioni delle AI – sono di vario tipo. Molte sono già state immaginate, da decenni, dagli autori di fantascienza e sono state elencate dalla presidente dell’Istituto Foresight Julia Bossmann in un articolo pubblicato sul sito del World Economic Forum. Il Post le ha riassunte mettendo insieme anche le opinioni di alcuni esperti di etica e di AI, più o meno positive sulle inclinazioni morali dei futuri HAL 9000.

I robot, il lavoro e le ineguaglianze

La questione di cui si parla di più sui robot e sulle intelligenze artificiali è relativa all’impatto del loro sviluppo sul mercato del lavoro. Secondo molti studi nei prossimi decenni l’introduzione di nuove tecnologie farà aumentare la produttività delle aziende ma al tempo stesso porterà a una diminuzione dei posti di lavoro difficile da compensare con la creazione di nuove opportunità di impiego a meno che i governi non prendano provvedimenti. Ad esempio, uno studio della società di consulenza PwC sul mercato del lavoro britannico ha stimato che nei prossimi 15 anni i sistemi di intelligenza artificiale potrebbero sostituire le persone nel 30 per cento dei posti di lavoro nel Regno Unito. Questo fenomeno potrebbe creare molti problemi anche perché potrebbe aumentare le ineguaglianze tra ricchi e poveri.

La dipendenza dalla tecnologia

Secondo Julia Bossmann, un altro problema legato allo sviluppo delle intelligenze artificiali, uno di quelli da affrontare in fretta, è legato alla nostra dipendenza dalla tecnologia. Per Bossmann il rischio è che i sistemi di AI del futuro siano capaci di attrarre la nostra attenzione attivando dei meccanismi di ricompensa nel nostro cervello come già fanno i videogiochi e gli algoritmi dei social network che ci propongono contenuti ai quali non sappiamo rinunciare. Secondo un articolo uscito di recente sul New York Times però la “dipendenza da videogiochi” non esisterebbe: lo sostengono due psicologi per cui non ci sono prove per sostenere la tesi della dipendenza e per cui, in ogni caso, giocare molto ai videogiochi non causa problemi paragonabili a quelli dell’abuso di alcol e droghe. Probabilmente l’accostamento con le droghe è sbagliato, tuttavia senza dubbio le nuove tecnologie avranno impatti sempre diversi sulle nostre vite e vale la pena occuparsene.

Nel romanzo fantascientifico del 1980 Solo il mimo canta al limitare del bosco lo scrittore americano Walter Tevis immaginò un futuro in cui gli esseri umani perdono qualsiasi capacità di badare a se stessi e sopravvivono solo grazie all’assistenza dei robot, passando la maggior parte del loro tempo sotto l’effetto di sostanze psicotrope. Senza arrivare a un estremo del genere, è probabile che con lo sviluppo delle AI l’affidamento alle macchine aumenti a tal punto da dover trovare regole comuni sul rapporto da tenere con esse.

Le AI possono essere razziste?

Si è cominciato a parlare anche di come i programmatori di AI – che sono esseri umani con i loro personali pregiudizi e le proprie personali convinzioni – possano influenzarne i processi decisionali dei software che realizzano, considerando che nel settore della tecnologia e della robotica lavorano soprattutto uomini e persone bianche. Un articolo di ProPublica spiega che un software, usato dalle autorità statunitensi per stimare le probabilità che una persona con un precedente penale commetta altri crimini, tende ad assegnare una maggiore probabilità ai neri rispetto ai bianchi. In altri casi alcuni software di riconoscimento facciale si sono dimostrati incapaci di riconoscere alcune caratteristiche di volti non bianchi. Un sistema di intelligenza artificiale autore di discriminazioni sarebbe molto dannoso anche nel campo del mercato del lavoro, se ad esempio fosse usato per scegliere i candidati più adatti a un dato posto di lavoro, come ha spiegato la sociologa esperta di tecnologia Zeynep Tufekci durante una recente conferenza TED, parlando anche di molte altre intersezioni tra robotica ed etica.

Secondo l’informatico Grady Booch, a sua volta autore di una conferenza TED sul tema delle intelligenze artificiali, il fatto che saranno gli esseri umani a programmare le AI sarà una garanzia sufficiente per avere computer che non commetteranno mai atti crudeli: saranno costruiti tenendo conto dei migliori valori adottati dalla comunità internazionale. Per questo Booch è molto ottimista e crede che chi riflette sulle AI non dovrebbe concentrarsi sui rischi più lontani nel tempo, ma su quelli che riguardano più da vicino le persone, a cominciare dal tema della perdita di posti di lavoro.

La stupidità artificiale e la sicurezza

Un’altra cosa a cui Bossmann suggerisce di fare attenzione è la cosiddetta “stupidità artificiale”, cioè quei difetti dei sistemi di AI che potrebbero renderli ingannabili dagli esseri umani o dalle circostanze. Ad esempio, schemi di punti disposti in modo casuale potrebbero far credere a un robot di “vedere” qualcosa che non esiste. Per questa ragione è importante che le macchine intelligenti siano progettate prevedendo i modi in cui qualcuno potrebbe usarle in modo sbagliato, facendo leva sulle loro “debolezze”.

Questo è particolarmente importante per quelle macchine, come i droni, che possono essere usate per danneggiare oggetti o ferire le persone. Per garantire che questo tipo di macchine sia sempre usato nel modo più appropriato è anche importantissimo che chi le progetta lavori a sistemi di sicurezza che impedisca a persone malintenzionate di modificare il loro sistema e usarle per scopi diversi da quelli per cui sono state progettate.

Cattivi senza volere

A partire dagli anni Quaranta lo scrittore di fantascienza Isaac Asimov immaginò “Tre leggi della robotica” ideate per regolare il comportamento dei robot. Le tre leggi sono:

I. Un robot non può recar danno a un essere umano né può permettere che, a causa del proprio mancato intervento, un essere umano riceva danno.

II. Un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non contravvengano alla Prima Legge.

III. Un robot deve proteggere la propria esistenza, purché questa autodifesa non contrasti con la Prima o con la Seconda Legge.

Con queste leggi e con i racconti in cui ne venivano dimostrate le debolezze, Asimov anticipò un’altra delle questioni etiche con cui i programmatori di AI si dovranno confrontare nei prossimi anni: può darsi che senza volere un robot faccia qualcosa di sbagliato perché incapace di comprendere il contesto in cui si trova. Bossmann suggerisce l’esempio estremo (e contrario alle leggi di Asimov) in cui a un sistema di AI sia chiesto di eliminare il cancro dal mondo e questo decida di risolvere il problema uccidendo tutti gli esseri viventi del pianeta, come un genio della lampada malvagio, ma solo in virtù di un principio di efficienza. Anche quello di HAL 9000 di 2001: Odissea nello Spazio è un caso simile. Molto più vicino a noi è il caso delle automobili che si guidano da sole. Non si sa chi potrebbe decidere come programmarle decidendo le regole della loro morale: potrebbero farlo gli stati e le leggi, potrebbero farlo i produttori oppure gli acquirenti stessi decidendo di impostare il “livello di moralità” della loro auto. Per ora il problema etico, di sicuro molto complesso e legato indissolubilmente alle debolezze delle tre leggi di Asimov, è senza risposte.

Il rischio della singolarità

Una delle domande inevitabili quando si pensa ai sistemi di intelligenza artificiale è se un giorno diventeranno più intelligenti di noi e vorranno imporsi come esseri superiori. Questa evenienza, il momento in cui gli esseri umani non saranno più gli esseri più intelligenti sulla Terra, è una delle cosiddette “singolarità”. Secondo i più ottimisti, questo non avverrà mai perché gli esseri umani potranno sempre staccare la spina, secondo altri questa argomentazione non ha senso perché sistemi artificiali tanto intelligenti saranno in grado di evitare di essere messi fuori gioco così semplicemente. In un breve video, che somiglia molto a un episodio della serie tv distopica Black Mirror, il Guardian ha immaginato l’incontro tra un androide intelligentissimo di nome Günther e un’esperta di etica, chiamata per dare una consulenza su come costruire un algoritmo che permetta alle intelligenze artificiali di distinguere il bene dal male. Nel video Günther raggiunge la singolarità e arriva a pensare che gli esseri umani non siano ancora abbastanza sviluppati per poter disporre di un cervello come il suo e per questo sparisce.

La questione dei diritti dei robot

Infine, tra le più lontane delle questioni etiche che andranno affrontate con lo sviluppo tecnologico c’è quella dello status giuridico dei sistemi di AI. A un certo punto li dovremo considerare come consideriamo gli altri animali o dargli ancora più diritti? Prenderemo mai in considerazione la loro sofferenza, se un giorno saranno in grado di soffrire? Anche in questo caso le questioni sembrano più vicine alla fantascienza (ad esempio, quella di L’uomo bicentenario, il film del 1999 con Robin Williams tratto dall’omonimo racconto di Asimov) che all’etica.