Per commentare questo articolo, dovete superare un test

È l'idea di un sito di tecnologia norvegese per assicurarsi che i lettori abbiano davvero letto e capito l'articolo che vogliono commentare (e che moderino i toni)

Da qualche settimana NRKbeta, un sito di news di tecnologia che fa parte della tv di stato norvegese, sta sperimentando un nuovo sistema per la moderazione dei commenti: per poter commentare alcuni articoli, ciascun lettore deve rispondere correttamente a un piccolo quiz per dimostrare di avere effettivamente letto il testo dell’articolo.

Il direttore di NRKbeta Marius Arnesen ha raccontato a Nieman Lab che l’esigenza di un sistema più efficace di moderazione è nata quando alcuni articoli hanno raggiunto lettori al di fuori della “bolla” degli appassionati di tecnologia che forma la base dei commentatori del sito, per esempio quando un articolo di NRKbeta è apparso nella homepage di NRK, il sito principale del gruppo: in quel momento «siamo stati raggiunti da molte persone che non sono molto a loro agio con i toni da usare online». Al momento solamente alcuni articoli sono provvisti di questo sistema di moderazione: quelli considerati più “a rischio” perché trattano un tema particolarmente delicato.

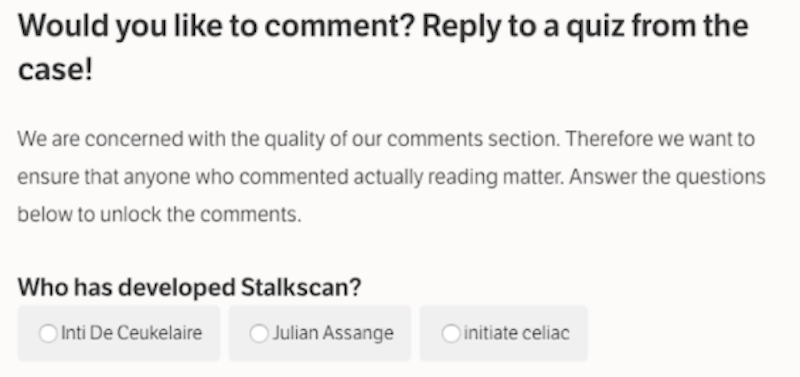

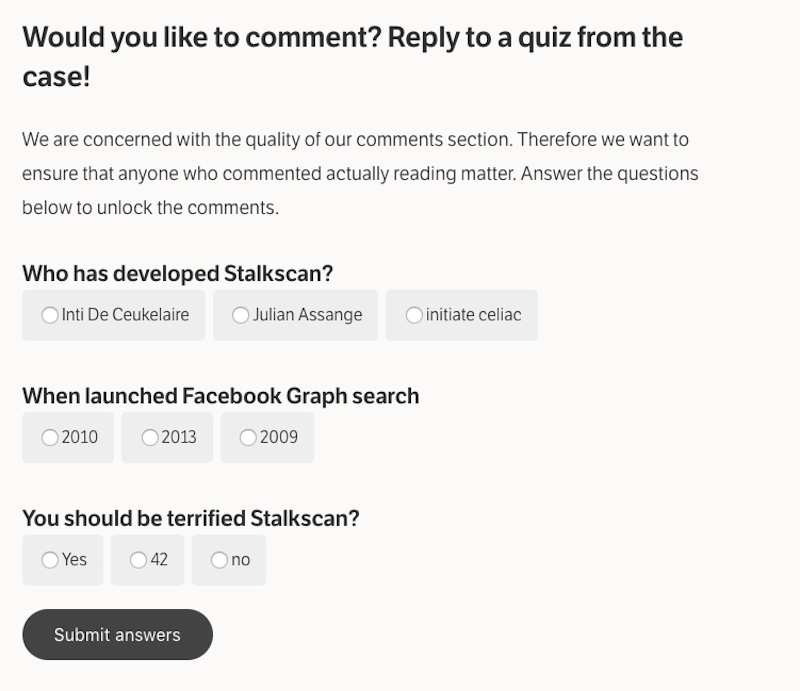

Il quiz si presenta in forma di un modulo con tre domande, scelte a caso da un archivio che ne contiene molte di più: Mashable ne ha tradotto uno dal norvegese all’inglese relativo a un articolo su Stalkscan, un sito che permette di visualizzare in un’unica schermata moltissime informazioni che Facebook possiede sul conto di ciascun utente, ma che solitamente non sono visibili. Le prime due domande sono di banale comprensione del testo: le due risposte si trovano rispettivamente all’undicesimo e al terzo paragrafo (e la prima è piuttosto intuitiva, anche se non si è letto l’articolo con attenzione).

La terza è meno definita, e potenzialmente più problematica: chiede se ciascun lettore dovrebbe sentirsi “terrorizzato” da Stalkscan. Il tema è un po’ scivoloso: qualcuno potrebbe obiettare che in questo caso non esiste una risposta corretta, e che ciascuno è libero di pensare di Stalkscan quello che vuole. La domanda insomma è un po’ maldestra, ma si riferisce a una delle conclusioni dell’articolo: nessuno dovrebbe essere terrorizzato da Stalkscan, perché mostra solo dati già pubblici (e anzi, potrebbe incentivare qualche utente a rendere private alcune informazioni sul proprio conto che non credeva potessero essere così accessibili). Nessuna delle tre domande, comunque, richiede informazioni pregresse che possano impedire di commentare a un lettore che fino a tre minuti prima non sapeva nulla di Stalkscan.

Come spiegato da alcuni giornalisti di NRKbeta a Nieman Lab, gli obiettivi del quiz sono sostanzialmente due: assicurarsi che i lettori siano davvero arrivati in fondo a un certo articolo prima di commentarlo, e far passare un po’ di tempo fra il momento in cui un lettore decide di commentare e quello in cui scrive materialmente il proprio commento: «se ti concentri sul commento che vuoi scrivere per altri 15 secondi, magari in quel lasso di tempo scegli di ammorbidire l’invettiva che stavi per scrivere», ha spiegato a Nieman Lab il direttore di NRKbeta Marius Arnesen.

Per il momento sembra che il nuovo sistema stia funzionando: due settimane fa NRKbeta ha pubblicato un articolo di approfondimento su una nuova legge norvegese sulla sorveglianza digitale – un tema molto delicato e su cui esistono posizioni molto forti, anche all’interno della stessa comunità di lettori affezionati – e la discussione si è rivelata molto civile, fra commenti costruttivi e segnalazioni di libri e articoli rilevanti sul tema.

Nemmeno a NRKbeta, però, sono convinti che questo approccio sia risolutivo sulla questione dei commenti aggressivi, fuori tema o ignoranti: per ora è un’eccezione alle consuete regole di moderazione, anche perché prevede un lavoro supplementare per l’autore dell’articolo (che per ora si impegna anche a scrivere le domande). Al momento inoltre diverse società che stanno provando a risolvere i problemi legati alla moderazione dei commenti online si stanno muovendo in direzioni diverse: la settimana scorsa Alphabet, la società che controlla Google, ha avviato un progetto per utilizzare sistemi di intelligenza artificiale per migliorare la moderazione automatica, mentre New York Times, Washington Post e Mozilla Foundation stanno lavorando da tempo al Coral Project, un progetto molto articolato che ha l’obiettivo di rendere più protetti e civili i luoghi online di discussione fra lettori e giornalisti.